AI-детекторы ботов в 2026: как работают и как не ломать опыт реальных пользователей

Содержание статьи

- Введение: почему тема актуальна, что узнает читатель

- Основы: фундаментальные концепции (для новичков)

- Глубокое погружение: продвинутые аспекты темы

- Практика 1: проектируем «легитимность по умолчанию» и снижаем ложные блокировки

- Практика 2: калибровка cloudflare turnstile, perimeterx и datadome для низкого трения

- Практика 3: этичное тестирование и песочницы для валидации антибот-защиты

- Практика 4: поведенческие сигналы и ux без трения

- Практика 5: роль мобильных сетей и прокси — что они меняют на стороне защиты

- Практика 6: модели, фичи и mlops-ревю вашего антибот-стека

- Типичные ошибки: что не нужно делать

- Инструменты и ресурсы: что использовать

- Кейсы и результаты: реальные примеры применения

- Faq: 10 глубоких вопросов

- Заключение: резюме, следующие шаги

Введение: почему тема актуальна, что узнает читатель

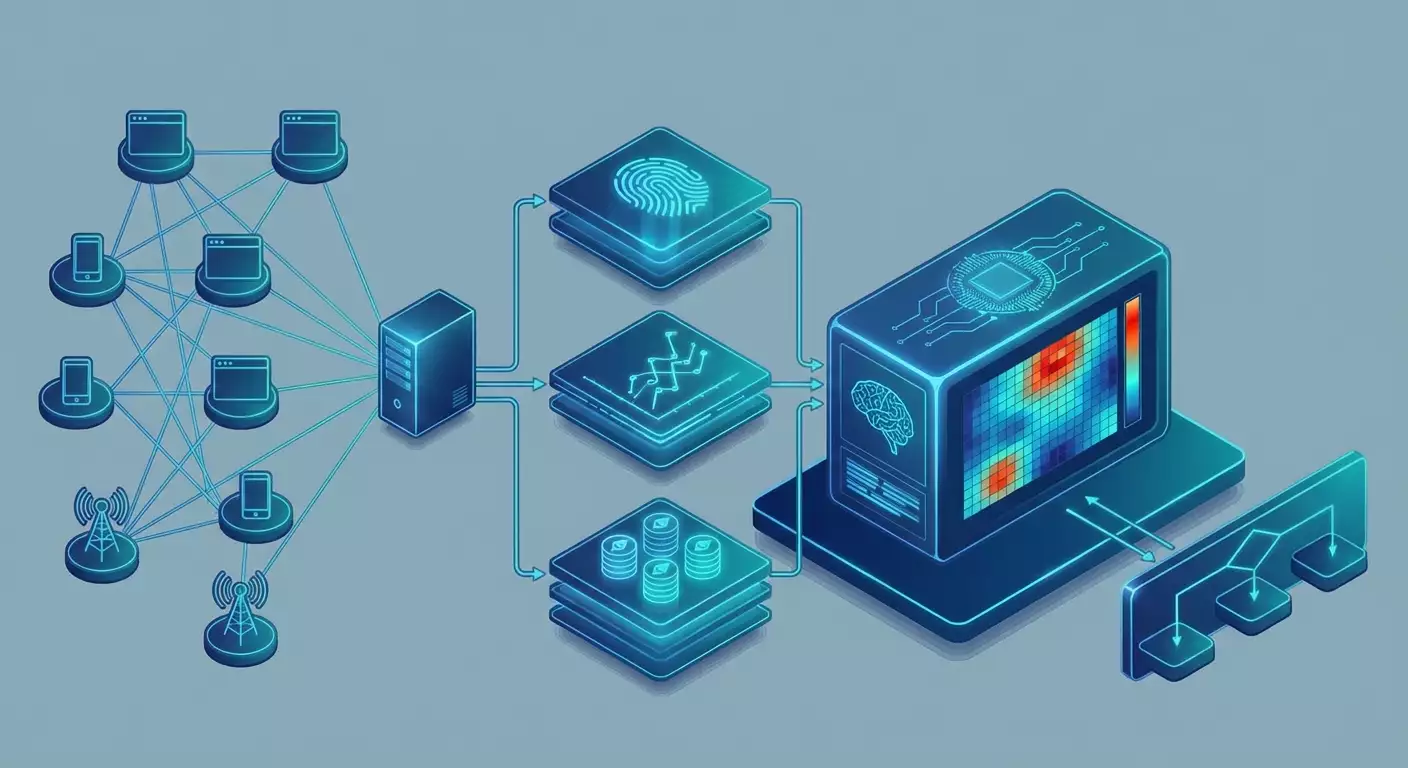

В 2026 году доля не-человеческого трафика остается на исторических максимумах, а уязвимость цифровых бизнесов к автоматизированным злоупотреблениям сохраняется. По оценкам ряда отраслевых отчетов за 2024–2025 годы, близко к половине всего трафика составляют боты, причем треть из них — злоумышленники, а остальное — доброкачественные роботы поисковиков, мониторинговые агенты и служебная интеграция. Вместе с этим сервисы защиты эволюционируют: от простых CAPTCHA к многофакторным поведенческим моделям и криптографической аттестации устройств. Команды продуктовой разработки, безопасности и рост-хаков сталкиваются с одной задачей: как защитить бизнес от ботов, не ломая опыт реальных пользователей и партнерских интеграций.

Это руководство — ориентир для руководителей, инженеров и аналитиков. Мы системно разберем, как сегодня работают AI-детекторы ботов: Cloudflare Turnstile, решения PerimeterX (бренд HUMAN) и DataDome. Объясним, что такое fingerprinting и поведенческий анализ, как устроены ML-модели, почему мобильные сети дают уникальные сигналы, и как выстроить этичное тестирование. Мы не даем и не поддерживаем инструкции по обходу защиты. Наша цель — помочь вам снизить риск, уменьшить ложные срабатывания и встроить легитимную автоматизацию на условиях прозрачности и соблюдения правил.

Что вы получите: современную таксономию сигналов, практические фреймворки калибровки систем и снижения трения, чек-листы внедрения, пошаговые схемы этичного тестирования в песочнице, типичные ошибки и решения, набор инструментов, а также реальные кейсы с измеримыми результатами. Дальше — конкретика и глубина.

Основы: фундаментальные концепции (для новичков)

Что такое бот-детекция. Бот-менеджмент — это набор серверных и клиентских механизмов, которые присваивают каждому запросу риск-оценку на основании множества сигналов: сети, устройства, поведения, истории сессии и контекста. При превышении порогов система может: пропустить запрос, применить фрикционную проверку (например, Turnstile), замедлить, потребовать аутентификацию или заблокировать.

Типы трафика. Принято выделять три слоя: доброкачественные боты (поисковые краулеры, uptime-агенты), серый слой (скрипты интеграций, кастомные RPA с разрешением владельца ресурса) и злоумышленники (скрейперы контента без разрешения, атаки на логины, карт-атаки, скальпинг). Политика обработки каждого слоя различается и закрепляется в политике безопасности, robots.txt, партнерских соглашениях и профилях allowlist.

Каналы сигналов. 1) Сетевые: IP-репутация, ASN, гео, портовые аномалии, TLS-отпечатки, стабильность RTT и Jitter. 2) Клиентские: браузерные свойства, стек шрифтов, WebGL/Canvas отпечатки, сенсорные данные, временные зоны, энергия батареи (мобильные), свойства платформы. 3) Поведенческие: ритм кликов, прокрутка, фокусы полей, задержки, траектория курсора, паттерны касаний. 4) Исторические: профиль сессии, частота и повторяемость действий, конверсии. 5) Криптографические: аттестация устройства/браузера и приватные токены доступа.

Решение и действия. Системы формируют риск-скор (например, 0–100). На основании порога применяются правила: пропуск, вызов интерактивного или скрытого челленджа, запрет на чувствительные операции, отложенная проверка. Важно понимать, что цель — не абсолютная блокировка, а управление риском: минимизировать атакующие сценарии при минимальном трении для реальных пользователей.

Этическая и правовая рамка. Законное использование автоматизации требует: соблюдения условий сервиса (ToS), robots.txt, получения явного разрешения, аккуратной идентификации своих агентов, и хранения данных с учетом приватности. Любая попытка скрытой маскировки под пользователя без разрешения может нарушать право, привести к блокировкам и репутационным рискам. В этом руководстве мы исходим из принципов комплаенса.

Глубокое погружение: продвинутые аспекты темы

Cloudflare Turnstile в 2026 — это «не-CAPTCHA» челлендж, который интегрируется в экосистему Cloudflare Bot Management. Он может опираться на Private Access Tokens (PATs) от производителей ОС и браузеров, сигнализирующие о подлинности клиента без раскрытия личности. Классическая модель: 1) скрипт на странице собирает неинвазивные сигналы, 2) сервер Cloudflare рассчитывает риск, 3) при необходимости пользователь незаметно подтверждается, 4) в сложных случаях появляется легкий челлендж. Сильная сторона — масштабная сетево-корреляционная репутация и криптографическая аттестация.

PerimeterX (HUMAN) — зрелая платформа, ориентированная на защите e-commerce и логинов. Она объединяет сигналы клиентской телеметрии, поведенческие профили, серверные маркировки и сеть разведданных. Внимание уделяется высокочастотным атакам (credential stuffing, карт-атаки). Продукт строит долгосрочные профили и отрабатывает решения как «Silent Mode» (без трения), так и интерактивные проверки, когда риск высок.

DataDome — сильный игрок на рынке антибот-решений, известен балансом между клиентскими и серверными мерами, широким покрытием интеграций (edge, SDK, ваф-плагины). Сервис активно использует ML-скоринг, репутацию IP/ASN, отпечатки TLS, и эвристики, рассчитанные на специфичные домены: билеты, маркетплейсы, SaaS. Принципиальная идея — постоянный фидбек-луп: верификация результатов в контексте конверсий и инцидентов.

Fingerprinting в 2026 — это уже не про один отпечаток Canvas, а про ансамбль слабых признаков: стабильность шрифтов, GPU-специфику, формирование TLS ClientHello, рантайм-артефакты движка, частоты датчиков, шум сенсоров и прочее. Современные браузеры внедряют антифингерпринтинг (Safari, Firefox), а платформы предлагают приватные токены, снижая потребность в агрессивном сборе сигналов. Защита использует кумулятивные вероятности; одиночный признак редко решающий.

Поведенческий анализ фиксирует микродинамику взаимодействия: распределение времени между событиями, микрофлуктуации траекторий, контекст переходов, последовательность действий. Здесь важны не «идеальные человеческие движения» (это миф), а согласованность паттерна с популяцией. Улучшение точности достигается за счет обучения на больших эталонных выборках и нормализации по сегментам устройств, локалей и сценариев.

ML-модели — ансамбли градиентных бустингов, графовых моделей и нейронных сетей, обученные на миллиардах запросов. Важная тенденция 2025–2026: сдвиг к модели «privacy by design», использование федеративного обучения, дифференциальной приватности и минимизации собираемых полей. На практике это дает меньше ложноположительных срабатываний и предсказуемость.

Криптографическая аттестация усиливает экосистему: Private Access Tokens, аттестация устройств мобильных ОС, платформенные сигналы целостности. Это снижает потребность в инвазивном слежении и позволяет честным клиентам проходить незаметно, если они действуют в рамках правил. Для владельцев ресурсов это ключ к низкому трению.

Практика 1: Проектируем «легитимность по умолчанию» и снижаем ложные блокировки

Цель: чтобы ваши реальные пользователи и разрешенные автоматизации проходили незаметно, а атаки — отсеивались. Мы не обходим системы, а выстраиваем архитектуру, в которой защита доверяет нам.

Фреймворк LEGIT-6

- Legal: фиксация правовой базы — ToS, соглашения с партнерами, robots.txt, политика данных.

- Expose: официальные интеграционные интерфейсы — публичные API, webhooks, каналы экспорта, выделенные endpoints с отдельными лимитами.

- Govern: политика идентификации автоматизации — отдельные ключи, подпись запросов, стабильные User-Agent и метаданные, договоренности об allowlist/verified bot.

- Instrument: прозрачная телеметрия — трассировка, корреляционные ID, атрибуты сессии, чтобы команды защиты видели контекст.

- Tune: совместная калибровка порогов и правил детектора с безопасностью и продуктом на основании данных.

- 6: шестинедельный цикл улучшений — гипотезы, эксперименты A/B, ретро.

Пошаговая инструкция

- Картирование трафика: разберите пользовательские и системные флоу, классифицируйте типы запросов и чувствительные операции. Отметьте источники: браузер, мобильное приложение, интеграция партнера, внутренние агенты.

- Официальные каналы: где возможно, переведите интеграции с парсинга HTML на API с OAuth2/токенами. Это резко снижает риск ложных срабатываний и дает лучшее наблюдение.

- Идентификация: договоритесь с владельцами антибот-решения о статусе «проверенный бот» для ваших служебных агентов. Используйте стабильные IP/ASN или выделенные подписи и ключи.

- Сигналы доверия: обеспечьте корректные заголовки, консистентный TLS-стек, честный User-Agent. Исключите маскировку и рандомизацию без нужды — детекторы накажут за нестабильность.

- Риск-правила: задайте политики: какие операции можно замедлять, где требовать дополнительную аутентификацию, как реагировать на подозрительный всплеск.

- Наблюдаемость: включите логи детектора, свяжите их с метриками продукта (конверсия, ретеншн), настройте алерты по FP/FN.

Чек-лист приемки

- API покрывают ≥80% интеграционных сценариев.

- Служебные агенты идентифицированы и согласованы с безопасностью.

- Пороговые правила задокументированы с примерами.

- Логи антибота связаны с аналитикой бизнеса.

- Выполнено тестирование доступности для ассистивных технологий.

Практика 2: Калибровка Cloudflare Turnstile, PerimeterX и DataDome для низкого трения

Принцип: каждый продукт уникален, но общая логика такова — чем богаче контекст и обратная связь от вас, тем точнее решения. Используйте режимы наблюдения, этапную валидацию и совместную настройку с вендором.

Cloudflare Turnstile и Bot Management

- Этап 1 — Наблюдение: включите детекцию без блокировки на ограниченном трафике (например, 10–20%). Снимите распределения риск-скоров по сегментам устройств и стран.

- Этап 2 — Сигналы: проверьте корректную инициализацию клиентского скрипта, стабильность загрузки, отсутствие конфликтов с CSP. Убедитесь, что Private Access Tokens используются там, где доступны.

- Этап 3 — Порог: установите стартовый порог так, чтобы честные пользователи видели челлендж менее чем в 0.5–1% случаев. Настройте исключения для известных интеграций.

- Этап 4 — Экшены: определите мягкие реакции на средний риск: замедление, повторная проверка, вторичный фактор для критичных операций (например, сохранение платежа).

- Этап 5 — Ревью: еженедельная сверка FP/FN с выборкой обращений в поддержку и с фидбеком from-product.

PerimeterX (HUMAN)

- Активируйте долгоживущие профили: это уменьшит влияние редких аномалий и стабилизирует риск-скор.

- Разнесите политики по эндпойнтам: логин, корзина, чек-аут — разные пороги и реакции.

- Сведите инциденты карт-атак в отдельные плейбуки, чтобы временно ужесточать правила без ущерба для остальных флоу.

DataDome

- Используйте гибкость SDK и edge-интеграций: часть логики держите на периметре, часть — в приложении.

- Поддерживайте «feedback API» — возвращайте информацию о реальных конверсиях и отменах, чтобы модель различала сложные кейсы.

- Внедрите «safe mode» на время крупных релизов фронтенда, чтобы не получить всплеск ложных срабатываний.

Метрики успеха

- Частота челленджей у реальных пользователей: ≤1% на ключевых страницах.

- Снижение атак на логины: ≥60% при стабильной конверсии аутентификации.

- Время загрузки страницы не увеличено более чем на 50–80 мс p95 из-за скриптов защиты.

- Снижение обращений в поддержку, связанных с блокировками: ≥30% после калибровки.

Практика 3: Этичное тестирование и песочницы для валидации антибот-защиты

Почему это важно: без воспроизводимых тестов команды рискуют либо перетянуть гайки и терять клиентов, либо недокрутить и пропустить атаки. Этичное тестирование — это согласованные сценарии в контролируемой среде с явным разрешением.

Пошаговая методика SAFE-RUN

- Scope: определите цели теста: пропускная способность, стабильность челленджа, устойчивость к шуму, влияние на UX.

- Authorize: оформите письменное разрешение и временные политики от владельца защиты. Настройте тестовые домены, ключи, песочницу.

- Fabricate: создайте генераторы трафика, имитирующие разные профили устройств и сетей, но с явной идентификацией теста и ограничением частот.

- Evaluate: измерьте риск-скоры, челлендж-рейтинг, латентность, долю FP. Сопоставьте с эталонными целями.

- Refine: вместе с вендором подстройте пороги, исключения, механизмы обратной связи.

Чек-лист тестовой гигиены

- Тестовая среда изолирована от продакшна или помечена иным доменом/ключом.

- Все тестовые агенты явно идентифицированы (заголовки, параметр запроса, трассировка).

- Нагрузки ограничены, чтобы не влиять на реальных пользователей.

- Журналирование включает аннотированные кейсы FP/FN с контекстом.

- После тестов правила откатываются, временные исключения закрываются.

Практика 4: Поведенческие сигналы и UX без трения

Идея: сильная защита не должна ощущаться пользователем. Поведенческие сигналы можно собирать минимально инвазивно, чтобы модели работали, а UX оставался приятным.

Технические советы

- Качество событий: отправляйте агрегированные метрики вместо сырых координат, где это уместно для приватности: гистограммы задержек, частоты взаимодействий, длительности сессий.

- Стабильность телеметрии: следите за потерями событий, пакетной отправкой, повторной передачей при оффлайне (мобайл).

- Доступность: телеметрия не должна мешать ассистивным технологиям. Тестируйте с экранными читателями и клавиатурной навигацией.

- Градиент трения: применяйте многослойные реакции: от «невидимого» скоринга до мягких челленджей и только затем — жестких блокировок.

Пошаговая интеграция

- Определите минимальный набор поведенческих сигналов под вашу модель.

- Внедрите сбор через SDK вендора или свой легковесный слой с агрегированием.

- Проведите A/B-тест: без сигналов vs с сигналами.

- Оцените эффект на FP/FN и Core Web Vitals.

- Откорректируйте частоту и объем телеметрии.

Практика 5: Роль мобильных сетей и прокси — что они меняют на стороне защиты

Контекст: мобильные сети с плотным CGNAT, частыми сменами IP, нестабильной задержкой и энергосберегающими профилями устройств создают уникальные паттерны. Детекторы учитывают это, чтобы не штрафовать реальных пользователей.

Что важно знать

- Сетевые аномалии: многие пользователи делят один публичный IP, и это нормально для мобильных. Репутация IP становится менее информативной без учета контекста.

- Сигналы устройства: мобильные ОС предоставляют богатые, но приватные сигналы целостности. Там, где доступны приватные токены, честный мобильный клиент получает проход без трения.

- Про прокси: использование мобильных прокси допустимо в тестах и мониторинге только с явным согласием и соблюдением правил. Попытка маскировки идентичности под «типичного пользователя» в продакшне без разрешения — риск эскалации, блокировок и юридических последствий. Современные детекторы видят неконсистентность отпечатков и паттернов, и такие схемы не масштабируются.

Этичные сценарии применения

- Кросс-сетевое тестирование производительности и доступности с согласованных устройств/прокси, помеченных как тестовые.

- Диагностика региональных проблем (например, один оператор связи) в песочнице.

- Валидация UX на разных классах устройств без попыток скрыться от защиты.

Чек-лист соответствия

- Провайдер прокси — с явным согласием участников и прозрачной политикой.

- Тестовые прогоны — в рамках разрешений, с пониженной частотой и идентификацией.

- Отчетность — все сессии логируются и доступны для аудита.

Практика 6: Модели, фичи и MLOps-ревю вашего антибот-стека

Почему это критично: модели дрейфуют. Появляются новые браузеры, меняются паттерны устройств, эволюционирует трафик. Без регулярного MLOps-цикла точность падает.

Фреймворк ML-ANTIBOT

- Data: храните фичи с версионированием схем, источников и трансформаций. Обеспечьте справедливое покрытие по гео и устройствам.

- Labels: метки получайте из подтвержденных исходов: успешные покупки, валидные логины, зафлаженные мошенничества. Избегайте «зараженных» меток.

- Features: используйте ансамбль слабых признаков: сетевые, криптографические, тонкие клиентские и поведенческие. Атавистические фичи (одиночный Canvas) — недостаточны.

- Train: обучайте регулярно: rolling window, мониторьте drift и PSI (Population Stability Index).

- Serve: латентность p95 и p99 — под контроль (целитесь <100 мс на решение). Кэшируйте не-чувствительные решения.

- Explain: стройте интерпретируемые отчеты: какие признаки влияют, где риск ложных срабатываний.

План ревью каждые 90 дней

- Аудит фич и утечек приватности.

- Калибровка порогов под сезонность.

- Сравнение вендорских и внутренних моделей.

- Обновление плейбуков инцидентов и runbook поддержки.

Типичные ошибки: что НЕ нужно делать

- Ставить «все на максимум»: агрессивные правила без данных приводят к потере конверсии и росту поддержки.

- Пытаться маскироваться: рандомизация User-Agent, скрытое использование прокси и обход сигналов — путь к эскалации защиты, блокам ASN и репутационным рискам.

- Игнорировать официальные API: парсинг HTML вместо использования поддерживаемых интерфейсов приводит к хрупкости и конфликтам с защитой.

- Не иметь плана инцидентов: всплески атак неизбежны. Отсутствие плейбуков = долгие простои.

- Не тестировать доступность: защита, конфликтующая с ассистивными технологиями, бьет по лояльности и юридическим нормам.

- Хранить избыточные данные: лишние персональные поля повышают риски приватности без пользы для точности.

Инструменты и ресурсы: что использовать

Коммерческие решения

- Cloudflare Bot Management и Turnstile для интеграции на периметре и легкого челленджа.

- HUMAN (бывший PerimeterX) для e-commerce и защиты логинов с поведенческим профилированием.

- DataDome для гибкой балансировки серверной и клиентской защиты и быстрого деплоя.

- Arkose Labs для силовых челленджей в сценариях высоких ставок.

Открытый и инфраструктурный стек

- Системы логирования и трассировки: OpenTelemetry, ClickHouse/BigQuery для аналитики событий.

- ML-оркестрация: Feature Store, MLflow, Kubeflow для версионирования и мониторинга моделей.

- Тестовые раннеры: фреймворки нагрузочного тестирования и реплея трафика в песочнице.

- Фреймворки приватности: дифференциальная приватность, анонимизация полей, политики минимизации.

Орг-практики

- Плейбуки инцидентов: карт-атаки, credential stuffing, контент-скрейпинг.

- Процедуры allowlist/verified bot для служебных агентов и партнеров.

- Совместные квартальные ревью с вендорами с учетом данных бизнеса.

Кейсы и результаты: реальные примеры применения

Кейс 1: Маркетплейс и чек-аут

Задача: скачок карт-атак и рост ложных челленджей на странице оплаты. Решение: HUMAN включен в silent-режим на 2 недели, собраны распределения риск-скоров по устройствам, добавлены сигналы от платежного шлюза (AVS/CVV-результаты), сегментация правил по эндпойнтам (логин, корзина, чек-аут). Результат: снижение карт-атак на 72%, частота челленджей у честных — с 1.8% до 0.6%, конверсия оплаты +1.1 п.п., обращения в поддержку −28%.

Кейс 2: Медиа и контент-скрейпинг

Задача: массовый несанкционированный сбор контента, падение CPM из-за аномального трафика. Решение: DataDome на периметре, введение официального контентного API для партнеров, помеченные ключи и rate limit, деградация функциональности для подозрительных агентов вместо жестких блоков. Результат: снижение несанкционированного скрейпинга на 65%, доля «хороших» ботов в трафике выросла до 22%, жалобы партнеров почти обнулились, CPM восстановился на 15%.

Кейс 3: SaaS-платформа, FP у корпоративных клиентов

Задача: корпоративные прокси клиентов создавали нестабильные сигналы, детектор эскалировал челленджи. Решение: Cloudflare Turnstile в связке с Private Access Tokens, добавление allowlist по ASN клиентов, введение SSO с усиленной аутентификацией для чувствительных операций. Результат: −40% ложных челленджей, время входа p95 без изменения, NPS +6 пунктов.

Кейс 4: Внутренние служебные агенты

Задача: мониторинговые роботы иногда попадали под блокировку после обновлений фронтенда. Решение: регистрация агентов как verified bot, выделенные ключи, стабильный User-Agent, контрольная панель для наблюдения за их трафиком. Результат: 0 инцидентов за квартал, предсказуемость и удобство для SRE.

FAQ: 10 глубоких вопросов

1. Можно ли полностью отказаться от клиентской телеметрии и опираться только на сеть?

На одних сетевых сигналах точность будет ограничена: мобильные сети, CGNAT и IPv6-сегментация делают IP-репутацию шумной. Сбалансируйте подход: легкая клиентская телеметрия плюс криптографические токены и контекст.

2. Как минимизировать влияние защиты на Core Web Vitals?

Загружайте SDK асинхронно, используйте деликатные пакеты, кэшируйте решения, не блокируйте рендер. Следите, чтобы дополнительная латентность не превышала 50–80 мс p95, иначе пересмотрите сбор сигналов.

3. Нужен ли собственный антибот поверх вендора?

Часто достаточно кастомных правил поверх решений вендора: сегментированные пороги, бизнес-контекст, allowlist. Собственная ML-модель оправдана при крупных объемах и уникальных сценариях, если есть MLOps-компетенции.

4. Как работать с ложноположительными срабатываниями?

Ведите каталог FP-случаев, связывайте их с конверсиями и саппортом, проводите недельные ревью, настраивайте исключения по сегментам. Используйте soft-actions до блокировок.

5. Что делать, если партнер использует нестандартную автоматизацию?

Переведите на официальное API, выдайте отдельные ключи и лимиты, настройте политический профиль. Настаивайте на прозрачной идентификации — это выгодно всем.

6. Мобильные прокси помогают выглядеть как «реальный пользователь»?

Это заблуждение. Современные детекторы учитывают консистентность множества сигналов и быстро выявляют маскировку. Прокси уместны только для тестов по согласованным правилам и в песочнице.

7. Как совместить приватность и точность?

Используйте минимизацию данных, агрегированные поведенческие метрики, private access tokens и прозрачные уведомления. Точность повышается за счет контекста и обратной связи, а не избыточного сбора персональных данных.

8. Что с CAPTCHA? Она умирает?

Классические CAPTCHA теряют эффективность и ухудшают UX. Их заменяют «невидимые» оценки риска, поведенческие модели и криптографические аттестаты. В ряде сценариев необходимы более сильные челленджи, но точечно.

9. Как подготовиться к пикам атак?

Держите плейбуки на готове: временное ужесточение правил для конкретных эндпойнтов, включение сильных челленджей, усиление аутентификации. Подготовьте коммуникации с поддержкой и фронт-офисом.

10. Реакция на модельный дрейф?

Мониторьте PSI и ключевые метрики, выполняйте квартальные переобучения, валидируйте на свежей выборке, синхронизируйте пороги с сезонностью. Включите алерты на аномальную динамику FP/FN.

Заключение: резюме, следующие шаги

AI-детекторы ботов в 2026 — это слияние сетевых репутаций, богатой клиентской телеметрии, поведенческого анализа и криптографической аттестации. Экосистема Cloudflare Turnstile, HUMAN (PerimeterX) и DataDome предлагает зрелые инструменты, но их сила раскрывается только в связке с вашей архитектурой и процессами. Побеждает не тот, кто жестче, а тот, кто умнее управляет риском: дает легальный, прозрачный путь честным пользователям и партнерам и одновременно затрудняет жизнь злоумышленникам.

Ваши следующие шаги: 1) составьте карту трафика и уязвимых операций; 2) договоритесь о политике verified bot и переводе интеграций на API; 3) включите детектор в режим наблюдения и проведите калибровку; 4) запустите этичные песочные тесты; 5) заведите ML-ревью каждые 90 дней; 6) обновите плейбуки инцидентов. Двигайтесь по циклу улучшений и измеряйте эффект: меньше атак, меньше трения, больше доверия. Это и есть путь к устойчивому росту в мире, где роботы — это уже половина Интернета, а ваш бизнес должен оставаться человечным, быстрым и безопасным.