Crawlee для веб-скрапинга в 2026: практические кейсы, инструкции и сравнение

Содержание статьи

- Введение: какую проблему решает crawlee и почему это важно в 2026 году

- Обзор crawlee: ключевые возможности, которые дают преимущество

- Сценарий 1. seo-аналитика и мониторинг serp: сниппеты, paa и локальные выдачи

- Сценарий 2. мониторинг цен и ассортимента на маркетплейсах

- Сценарий 3. социальное слушание и отзывы: публичные страницы, форумы, q&a

- Сценарий 4. b2b-лидогенерация и обогащение данных: каталоги, реестры, сайты компаний

- Сценарий 5. агрегация вакансий и hr-аналитика: рынок, зарплаты, навыки

- Сценарий 6. недвижимость и классифайды: мониторинг предложения и цен

- Сценарий 7. контент-мониторинг конкурентов и медианалитика

- Технические основы crawlee, которые ускоряют внедрение

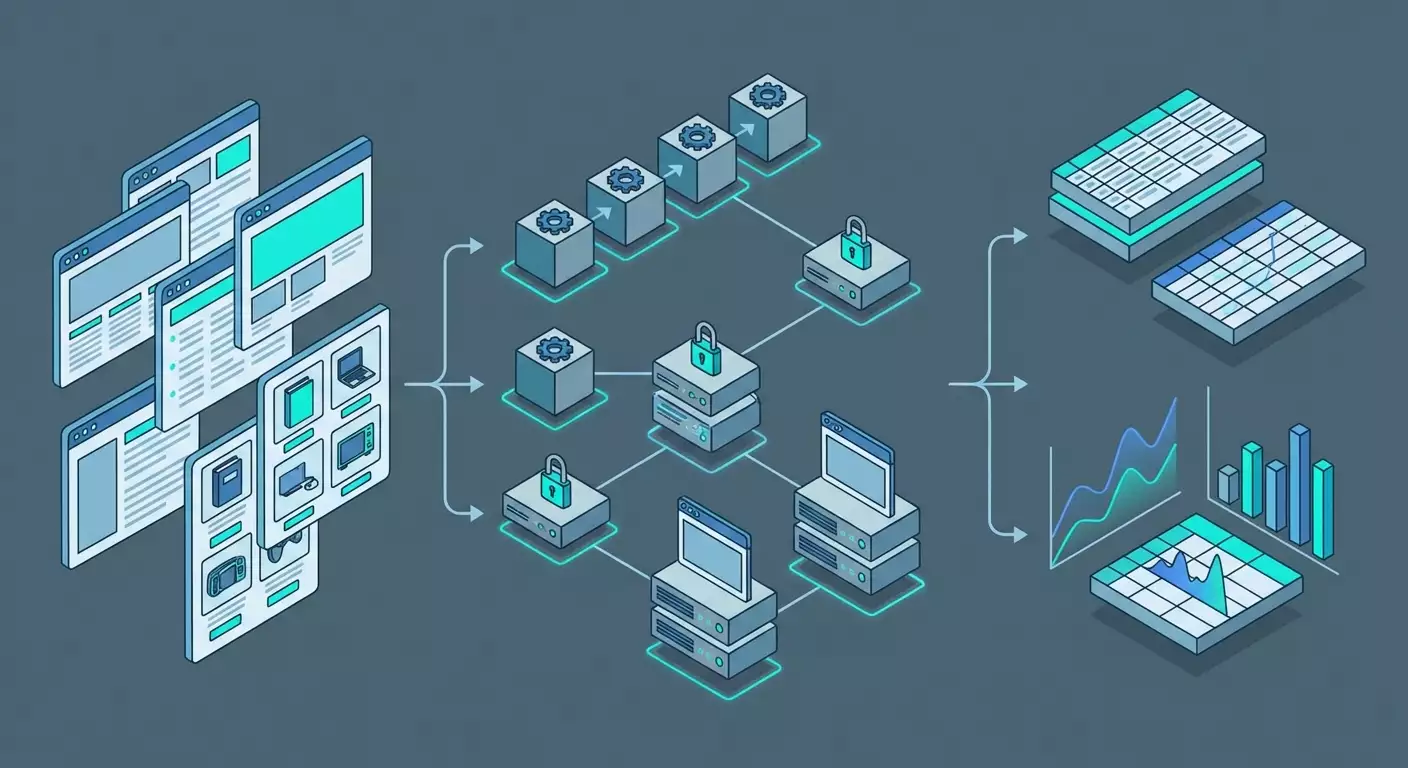

- Комбинации с другими инструментами

- Типичные грабли и как их избежать

- Сравнение с альтернативами: почему crawlee выигрывает у платных api

- Faq: коротко и по делу

- Выводы: кому подходит crawlee и как начать

Введение: какую проблему решает Crawlee и почему это важно в 2026 году

Веб стал главным источником рыночных сигналов: цены, остатки, отзывы, вакансии, новости, контент конкурентов, социальные тренды. Но простого «скачать страницу и распарсить» уже недостаточно. Вы сталкиваетесь с антибот-фильтрами, динамическим рендерингом, лимитами запросов, банами за подозрительную активность, а также с необходимостью быстро масштабировать сбор миллиона URL без потерь качества. В 2026 году это стандартная реальность любого data-driven бизнеса.

Crawlee — open-source фреймворк от Apify на TypeScript/JavaScript — закрывает ключевые операционные риски: ротация прокси, обход антибот-защит через stealth-режимы, управление очередями запросов, автоматические повторы с экспоненциальной задержкой, стабильный экспорт в JSON/CSV/базы, а также поддержка headless-браузеров и HTTP-парсинга. Фактически это «конструктор промышленного уровня» для разработки надежных парсеров, который позволяет разработчикам, SEO-специалистам и маркетологам запускать проекты быстрее, дешевле и безопаснее.

Хотите мониторить цены и ассортимент на маркетплейсах, собирать SERP и People Also Ask, тянуть публичные отзывы или вакансии? Crawlee уже включает готовые кирпичики под такие задачи. Ниже — обзор и 7 практических сценариев: кому полезно, как настроить, что получить на выходе и какие подводные камни вас поджидают.

Обзор Crawlee: ключевые возможности, которые дают преимущество

Технологический стек и движки

- PlaywrightCrawler и PuppeteerCrawler — для динамических страниц с рендерингом, эмуляцией действий пользователя и обходом антиботов через stealth-плагины, управление куками и session pooling.

- CheerioCrawler — высокопроизводительный HTTP-парсинг там, где JavaScript не обязателен. Идеален для новостных сайтов, каталогов, статических страниц, XML и RSS.

- BasicCrawler — низкоуровневый контроллер очереди и параллелизма для задач без HTML-парсинга или для API-first подхода.

Стабильность и антибот-обход

- Ротация прокси через ProxyConfiguration и встроенную интеграцию с провайдерами, включая мобильные прокси. Это критично для маркетплейсов, соцсетей и некоторых СМИ.

- Stealth-режимы с имитацией реального браузера: корректные заголовки, сигнатуры WebGL/Canvas, шрифты, тайминги и диспозиция событий.

- SessionPool и управление cookie для повышения доверия и снижения частоты капч.

- Автоматический retry с экспоненциальной задержкой и стратегиями бэкоффа. Снижает влияние временных сбоев и rate limiting.

Масштабирование и управление потоком

- RequestQueue и RequestList для управления URL и дедупликации.

- Автоскейлинг параллелизма на основе метрик загруженности CPU, памяти и задержек сети. Crawlee сам подбирает оптимальный уровень concurrency.

- Persisted storages для очередей, логов, снапшотов и датасетов. Подходит как для локальной разработки, так и для прод-окружений.

Вывод данных и интеграции

- Экспорт в JSON, CSV, NDJSON, а также в базы данных через коннекторы и кастомные writer-ы.

- Гибкая сериализация и схемы — организуйте единый data model для разных источников, объединяя результаты.

- Пайплайны с Airflow, Prefect, n8n, dbt, ClickHouse или BigQuery — через CLI и контейнеризацию.

Лицензия и сообщество

- Open-source, бесплатный, 20k+ звезд на GitHub. Живая экосистема и быстрые обновления. В 2026 году — один из стандартов де-факто в JS/TS-сообществе для скрапинга.

Ключевая идея: Crawlee усиливает вашу команду готовыми решениями для сложных зон — антибот-защита, масштабирование, очереди, устойчивость. Вы фокусируетесь на логике извлечения, а не на обвязке.

Сценарий 1. SEO-аналитика и мониторинг SERP: сниппеты, PAA и локальные выдачи

Для кого и зачем

Для SEO-специалистов, контент-маркетологов и агентств, которым нужна регулярная проверка позиций, сниппетов, People Also Ask, локальных паков и SERP features. Цель — увидеть, что реально показывает Google или другой поисковик пользователю в нужной стране, городе и на конкретном устройстве.

Как использовать Crawlee

- Подготовьте список запросов в RequestList: ключевые слова, регионы, языки.

- Включите ротацию прокси с гео-таргетингом. Для локальной выдачи используйте резидентские или мобильные прокси страны и города, которые вам важны.

- Выберите движок: PlaywrightCrawler для рендеринга и подгрузки PAA; CheerioCrawler — если выдача статична.

- Настройте SessionPool и user agent-миксы для снижения риска капч.

- Распарсьте структуры: заголовки, урлы, сниппеты, PAA-вопросы и ответы, наличие sitelinks, FAQ- или HowTo-разметки.

- Экспортируйте в CSV/JSON и отправьте в вашу DWH или Google Sheets через коннектор.

Пример и результат

Агентство отслеживало 2 500 запросов в 10 регионах. Переход на Crawlee с CheerioCrawler для базовых SERP и PlaywrightCrawler для PAA дал стабильную обработку 97% запросов без ручных вмешательств. За месяц нашли 38 «провалов» сниппетов из-за сбоя микроразметки и закрепили FAQ-блоки для 120 запросов. Итого — рост CTR на 7,3% и +14% трафика по группе брендов.

Лайфхаки и лучшие практики

- Тайминг: имитируйте поведение пользователя, добавляйте рандомные задержки 200–1200 мс между действиями.

- Geo-режим: используйте разные прокси-пулы для разных регионов и фиксируйте «мобильный» и «десктопный» user agent.

- Антидубли: хэшируйте выдачу и отслеживайте изменения. Храните только дельты — дешевле и легче анализировать.

- Снижение капч: увеличивайте «вес» сессии: сохраняйте cookies, имитируйте скролл, не взлетайте сразу на высокий concurrency.

Типичные ошибки

- Один прокси на все регионы. Итог — нерепрезентативная выдача и бан. Решение: резидентские/мобильные прокси под каждый регион.

- Игнорирование PAA/People Also Search For. Потеря инсайтов. Решение: PlaywrightCrawler с отдельным пайплайном.

- Без нормализации данных. Сравнивать сложно. Решение: единый словарь SERP-фич и унифицированные поля.

Сценарий 2. Мониторинг цен и ассортимента на маркетплейсах

Для кого и зачем

Для e-commerce менеджеров, брендов, дистрибьюторов и конкурентной разведки. Цель — видеть цены, остатки, наличие, скидки, позиции в категориях и выдаче; быстро реагировать на демпинг или дефицит.

Как использовать Crawlee

- Картографируйте каталоги: категории, фильтры, пагинации, карточки товара.

- Определите модель данных: SKU, название, цена, старая цена, наличие, рейтинг, отзывы, продавец, позиция, дата.

- Выберите движок: CheerioCrawler для каталогов со статикой, PlaywrightCrawler — для SPA и lazy-loading.

- Настройте RequestQueue с дедупликацией по SKU/URL и SessionPool, включите ротацию прокси. Для сложных площадок — мобильные прокси.

- Включите автоматический retry и экспоненциальный backoff для «шумных» страниц и всплесков капч.

- Постобработка: выявление ценовых аномалий, подсчет доли сток-оутов, изменение позиции, алерты в Slack/почту.

Пример и результат

Бренд мониторил 18 400 SKU в 5 маркетплейсах. Перешли на Crawlee, разделили пайплайны: CheerioCrawler для каталогов и PlaywrightCrawler только для карточек с динамическими блоками. Стабильно 92–95% покрытие с обновлением 2 раза в сутки. Обнаружили 312 случаев «серых» скидок и 1 120 разночтений по RRP. Итог — экономия маржи ~2,4% и ускорение реакции на аномалии с 48 часов до 6 часов.

Лайфхаки и лучшие практики

- Временные окна: запускайте обход в «мягкие» часы, когда антиботы менее агрессивны.

- Отдельные очереди для категорий и карточек товара — разное время жизни и разные риски.

- Обогащение: подтягивайте курсы валют и сопоставляйте цены в одной валюте.

- Кэширование изображений: сохраняйте хэши, чтобы понимать, когда меняются визуальные офферы.

Типичные ошибки

- Один crawler на все. Лучше разбивать на модули: каталог, карточка, отзывы.

- Игнорирование пагинаций-фильтров. Потеря ассортимента. Сделайте карту URL с параметрами.

- Отсутствие политики ретраев. Итоги неполные. Включайте повтор с backoff и «песочницу» для проблемных URL.

Сценарий 3. Социальное слушание и отзывы: публичные страницы, форумы, Q&A

Для кого и зачем

Для PR, маркетинга, саппорта и продуктовых команд. Цель — оперативно находить новые вопросы пользователей, негативные тренды, сравнения с конкурентами и кейсы использования. Это повышает NPS и сокращает churn.

Как использовать Crawlee

- Определите источники: публичные страницы отзывов, форумы, блоги, Q&A. Соблюдайте условия использования платформ и правовые ограничения.

- Разделите на типы: статические (CheerioCrawler) и динамические (PlaywrightCrawler).

- Настройте словари для фильтрации: брендовые запросы, продуктовые линии, ошибки, конкуренты.

- Реализуйте дедупликацию по URL и контент-хэшу, отслеживайте новые сообщения с датой/временем.

- Добавьте sentiment: отправляйте текст в вашу модель анализа тональности и темы (через сторонний сервис или локальную модель).

- Алерты при всплесках негатива, новых баг-репортах или аномально растущих темах.

Пример и результат

Финтех-проект мониторил 36 публичных источников. Crawlee позволил стабильно подтягивать ~4 500 единиц UGC в день с 89% точностью тематического рубрикатора. SLA оповещений — до 30 минут. Итог: время реакции саппорта на публичный негатив сократилось с 12 часов до 1,5 часов; удалось раннее обнаружение багов в андроид-приложении, что уменьшило отток на 0,6 п.п. за квартал.

Лайфхаки и лучшие практики

- Соблюдайте правовые нормы: парсите только публичные страницы, уважайте robots.txt и условия площадок.

- Гео-прокси для региональных форумов — иначе доступ может быть ограничен.

- Тональный микс: отслеживайте долю негатива/позитива по темам, а не только в целом.

- Хэштеги и упоминания: выделяйте как отдельные поля для точного поиска.

Типичные ошибки

- Сбор всего подряд. Взрывает расходы и ухудшает качество. Используйте словари и фильтры.

- Отсутствие дедупликации. Повторные сообщения и «шума» много. Делайте контент-хэши.

- Нулевой контекст. Храните ссылку на обсуждение, автора и ветку, иначе вы теряете смысл.

Сценарий 4. B2B-лидогенерация и обогащение данных: каталоги, реестры, сайты компаний

Для кого и зачем

Для sales- и growth-команд B2B. Цель — собирать сведения о компаниях, технологиях на сайте, контактные формы, страницы вакансий, структуру продуктов; затем обогащать CRM и запускать персонализированные касания.

Как использовать Crawlee

- Составьте seed-список: каталоги, отраслевые реестры, ассоциации.

- Снимите карту сайта по компаниям: главная, страницы продуктов, «О компании», вакансии, контакты.

- Извлекайте структуру: название, домен, технологический стек по признакам, размеры команды (через вакансии), регионы.

- Сделайте нормализацию: единый формат компаний и доменов, проверка дубликатов.

- Экспорт в CRM и обогащение через ваши сервисы по email-дискавери и валидации (соблюдая правовые ограничения).

- Ставьте метки ICP: отрасль, размер, стек — для приоритизации лидов.

Пример и результат

Аутсорс-компания собрала 12 700 доменов из 6 отраслевых каталогов и их собственных сайтов. Crawlee дал стабильную скорость 90–120 URL/мин на CheerioCrawler и 15–25 URL/мин на PlaywrightCrawler для глубокой проверки техстека. Заполнили 18 обязательных полей профиля, снизили дубль-лиды на 28% за счет доменных хэшей. Результат: рост reply rate с 3,8% до 5,1% благодаря персонализации кейсов под реальный стек клиента.

Лайфхаки и лучшие практики

- Технологический след: ищите JS-артефакты, мета-теги, атрибуты DOM, заголовки. Формируйте «техкарты» домена.

- Data contracts с продажами: согласуйте схему полей до запуска, исключите «мусорные» лиды.

- Регулярные обновления: ставьте частоту 30–45 дней, чтобы не устаревали данные.

Типичные ошибки

- Слишком глубокий краулинг без ценности. Ограничьте глубину и доменные правила.

- Нет сопоставления доменов с CRM. Вылетают дубли. Введите строгие ключи и нормализацию.

Сценарий 5. Агрегация вакансий и HR-аналитика: рынок, зарплаты, навыки

Для кого и зачем

Для рекрутинга, HR-аналитиков и образовательных платформ. Цель — мониторить динамику вакансий, вилки зарплат, востребованные навыки, стек технологий и географию найма.

Как использовать Crawlee

- Выберите источники: доски вакансий, карьерные разделы компаний, профессиональные форумы.

- Определите схему: должность, локация, занятость, зарплата, стек, требования, ссылка на компанию, дата публикации.

- Комбинируйте движки: CheerioCrawler для статичных досок, PlaywrightCrawler — для SPA и infinite scroll.

- Борьба с дубликатами: ключ = компания + должность + нормализованный город + дата. Храните хэш описания.

- Постобработка: извлекайте навыки NER-моделью, нормализуйте зарплаты по валютам, стройте тренды.

- Экспорт в аналитическое хранилище и дашборды.

Пример и результат

HR-аналитики агрегировали 150 000+ активных вакансий в месяц из 24 источников. Crawlee поддерживал конвейер 10–12 параллельных краулеров, давая 93% успешных загрузок. Выявили рост спроса на data инженеринг на 21% кв/кв и снижение вилок по фронтенду на 7–9% в EMEA. Эти данные помогли пересобрать приоритеты обучения и план найма.

Лайфхаки и лучшие практики

- Шаблоны вакансий: распознавайте повторяющиеся блоки и парсите по секциям, а не просто по тегам.

- Сезонность: сравнивайте год к году, иначе вы ловите «шумиху» отпусков и праздников.

- Вконтуре Crawlee храните не только вакансии, но и «снимки» карточек — пригодится для аудита.

Типичные ошибки

- Неправильная нормализация валют. Делайте кросс-курс на дату публикации.

- Пренебрежение гео-настройками. Гибрид/remote и onsite трактуются по-разному, учитывайте политики компаний.

Сценарий 6. Недвижимость и классифайды: мониторинг предложения и цен

Для кого и зачем

Для агентств, инвесторов и аналитиков рынка. Цель — видеть динамику цен, ликвидность, плотность предложений по районам, скорость продаж.

Как использовать Crawlee

- Разметьте категории: аренда, продажа, тип недвижимости, районы, фильтры.

- Определите атрибуты: цена, метраж, этаж, локация, телефоны/контакты, агентство, фото.

- Infinite scroll: PlaywrightCrawler с контролем событий прокрутки, таймингами и подгрузкой порций.

- Геокодинг: адрес в координаты через ваш геосервис; округляйте до кварталов, чтобы считать плотность.

- Антидубли: объявление+контакт+метраж как композитный ключ, контент-хэш описания.

- Аналитика: медианные цены, цена за метр, время жизни объявления, всплески, аномалии.

Пример и результат

Инвестфонд отслеживал 9 городов, 1,2 млн объявлений за квартал. Crawlee обеспечил 88–92% успешных загрузок на сложных SPA за счет распределения прокси и аккуратного скролла. Находили арбитражные возможности — лоты с ценой ниже медианы на 14–18% при нормальном времени экспозиции. ROI-пилот: +3,1 п.п. к доходности в подвыборке.

Лайфхаки и лучшие практики

- Темп прокрутки: имитируйте пользователя, подгружайте 2–3 порции, затем пауза, затем снова.

- Снимки фото: сохранение хэшей изображений помогает отлавливать старые объявления с новыми датами.

- Обратные проверки: регулярно «переходите» по карточкам из прошлой недели, чтобы понимать реальный time-to-sold.

Типичные ошибки

- Агрессивная скорость — капчи и баны. Держите умеренный concurrency, добавляйте jitter в задержки.

- Слабая гео-нормализация — неправильные выводы по районам. Используйте единый справочник гео.

Сценарий 7. Контент-мониторинг конкурентов и медианалитика

Для кого и зачем

Для продуктового маркетинга, PR и контент-команд. Цель — отслеживать публикации конкурентов, обновления лендингов, новые кейсы и техдокументацию; сравнивать месседжинг и запуски фич; готовить еженедельные дайджесты для руководства.

Как использовать Crawlee

- Составьте список доменов конкурентов, их блоги, поддомены docs, страницы changelog.

- Сканируйте на CheerioCrawler, сохраняйте канонические URL, заголовки H1–H3, дату публикации, авторов и структурированную разметку.

- Ставьте «сторожки» изменений: сравнивайте контент-хэши и извлекайте дельты.

- Классифицируйте публикации по темам: продукт, кейсы, партнерства, релизы.

- Формируйте дайджест и KPI: частота публикаций, доля продуктового контента, влияние на органику.

Пример и результат

Продуктовая компания мониторила 32 сайта конкурентов. Crawlee фиксировал изменения лендингов, помог найти скрытые обновления ценообразования и новый модуль интеграций. В результате команда подготовила контр-кампанию за 72 часа и удержала 9 стратегических клиентов, предотвращая churn в квартальном отчете.

Лайфхаки и лучшие практики

- Хэширование секций отдельно: hero, pricing, feature-grid. Это позволяет видеть, где именно изменения.

- Снимки DOM и сравнение по узлам — точнее простого текстового diff.

- Порог срабатывания: не реагируйте на минорные правки; заводите три уровня — минор, медиум, мажор.

Типичные ошибки

- Единый crawler для всего сайта. Разбивайте на разделы и разную частоту сканирования.

- Нет карты приоритетов. Важные страницы проверяйте чаще, второстепенные — реже.

Технические основы Crawlee, которые ускоряют внедрение

Компоненты фреймворка

- RequestQueue и RequestList: управление списками адресов, приоритетами и дедупликацией для стабильного потокового забора данных.

- SessionPool: хранение и обновление сессий с куками, надежный обход легких антиботов, снижение капч.

- ProxyConfiguration: гибкая ротация провайдеров, поддержка резидентских и мобильных прокси, фиксация гео.

- Автоскейлинг: динамическая подстройка числа параллельных задач под ресурсы и текущую ошибочность.

- Storages для логов, снапшотов, датасетов, key-value данных; экспорт в CSV, JSON, NDJSON.

Производительность и устойчивость

- Retry с backoff: задавайте максимум попыток, интервал и стратегии; логируйте причины падений.

- Политики таймаутов: разная высота для каталога, карточек и медиаконтента.

- Хелсчеки: периодические проверки процента ошибок, падения рейта, подписка на алерты.

Развертывание

- Локально для отладки, с последующим контейнером.

- Оркестрация пайплайнов через Airflow, Prefect или нативный планировщик; шедулинг по cron.

- Хранилища: PostgreSQL, ClickHouse, BigQuery, Elastic — через кастомные writer-ы и стриминг.

Комбинации с другими инструментами

- NLP и ML: нормализация сущностей, sentiment, классификация тем.

- BI: Metabase, Superset, Power BI, Looker или Grafana для дашбордов.

- ETL: dbt для моделирования схем, Airflow/Prefect для оркестрации, n8n/Make для простых интеграций.

- Очереди: Kafka или RabbitMQ, если нужны стриминговые пайплайны на миллионы событий в сутки.

Типичные грабли и как их избежать

- Игнорирование robots.txt. Всегда проверяйте политику сайта и соблюдайте ее.

- Гиперконкурентность. Слишком много параллельных потоков — капчи и баны.

- Без сенситивной паузы. Добавляйте случайные задержки и имитируйте поведение пользователя.

- Нет тестовых списков. Отлаживайте на небольших наборах URL.

- Смешение схем. Жестко определяйте схему данных, версионируйте ее.

Сравнение с альтернативами: почему Crawlee выигрывает у платных API

ScrapingBee и ZenRows

Это сильные платные API c рендерингом, встроенными прокси и фичами антибот-обхода. Порог входа низкий: отправляете запрос — получаете HTML. Но стоимость растет экспоненциально с объемом и сложностью. Меньше контроля, меньше гибкости в кастомных логиках браузера, сложнее добиться тонкой имитации поведения пользователя под конкретные сценарии. Внутренняя поддержка очередей, схем и автоскейлинга ограничена моделью «запрос—ответ».

Преимущества Crawlee

- Open-source и нулевая лицензия — снижает OPEX при больших объемах.

- Гибкая архитектура — собственные очереди, сессии, антидубли, сложные пайплайны.

- Глубокая интеграция браузера — точная имитация пользователя, управление рендерингом, ивентами, таймингом.

- Экспорт и хранилища — плотная интеграция с вашими DWH и схемами.

- Масштабирование — автоскейлинг, тонкая настройка параллельности, ретраев и политики таймаутов.

Когда брать платный API

Если вам нужен «быстрый старт» для малых объемов, без кастомной логики браузера, и вы не хотите управлять прокси и инфраструктурой. Для сложных долговременных проектов и экономии при больших потоках Crawlee обычно выигрывает.

FAQ: коротко и по делу

1. Законно ли использовать Crawlee?

Crawlee — инструмент. Законность зависит от того, что и как вы парсите. Соблюдайте условия сайтов, robots.txt и законы о защите данных. Парсите публичный контент, избегайте персональных данных без правовых оснований.

2. Как уменьшить капчи и баны?

Ротация прокси (включая мобильные), SessionPool, реалистичные user-agent, задержки с джиттером, умеренный concurrency, ограничение скорости по домену, постепенный разогрев.

3. Что выбирать: PlaywrightCrawler, PuppeteerCrawler или CheerioCrawler?

Если сайт рендерит контент на клиенте, берите Playwright или Puppeteer. Если HTML статичен — Cheerio в разы быстрее и дешевле. Часто комбинируйте: каталог на Cheerio, карточка на Playwright.

4. Как хранить и версионировать данные?

Используйте датасеты Crawlee, затем выгружайте в DWH. Введите версию схемы, поля updated_at, source_url, source_version. Для диффов храните контент-хэши.

5. Как запускать по расписанию и масштабировать?

Контейнеризуйте и оркестрируйте через планировщик. Разделите crawlers по доменам/разделам. Используйте горизонтальное масштабирование и автоскейлинг параллелизма.

6. Как справляться с Cloudflare и подобными защитами?

Stealth-режимы, реалистичные браузерные сигнатуры, повышение «веса» сессий, снижение скорости, мобильные прокси. Избегайте шаблонных паттернов поведения.

7. Как обрабатывать infinite scroll?

PlaywrightCrawler: пошаговые скроллы, ожидания загрузки порций, лимиты по количеству элементов, тайм-аут и контроль повторов.

8. Как избегать дублей?

Включите дедупликацию URL в RequestQueue и используйте контент-хэши. В бизнес-логике — составные ключи (например, SKU+дата).

9. Как быстро отлаживать парсер?

Локальная разработка с небольшим RequestList, визуализация DOM селекторов, логирование причин ошибок, snapshots проблемных страниц, unit-тесты для парсеров блоков.

10. Как экспортировать в CSV/JSON и базы?

Через встроенные датасеты в CSV/JSON/NDJSON или собственные writer-ы в PostgreSQL, ClickHouse и другие хранилища.

Выводы: кому подходит Crawlee и как начать

Кому подходит: разработчикам, SEO- и growth-командам, e-commerce менеджерам, аналитикам и продуктовым маркетологам, которым нужен надежный, масштабируемый и экономичный способ собирать веб-данные. Если вы хотите контролировать прокси, сессии, рендеринг и экспорт — Crawlee даст максимальную гибкость.

Как начать:

- Определите бизнес-цели и схему данных: какие поля и метрики вам нужны.

- Выберите движок: Cheerio для статичного, Playwright/Puppeteer для динамического.

- Соберите минимальный прототип на 50–100 URL с RequestList, экспортом в CSV и базовыми селекторами.

- Добавьте ProxyConfiguration, SessionPool, retry с backoff, антидубли и валидаторы данных.

- Разделите на модули: каталог, карточка, отзывы; настройте расписание и алерты.

- Подключите DWH и дашборды, введите SLA обновления и мониторинг качества.

В 2026 году выигрывают не те, кто «умеет парсить», а те, кто строит устойчивые конвейеры данных. Crawlee — инструмент, который позволяет превратить хаотичный веб в управляемые датасеты с измеримым бизнес-эффектом: более быстрые решения, точнее цены, выше конверсия и меньше слепых зон.