Обратные прокси для защиты корпоративных сетей: балансировка, кеширование и сценарии применения

Содержание статьи

- Введение: зачем нам реверсивный прокси в 2025 году

- Как работает обратный прокси: базовые принципы

- Балансировка нагрузки: алгоритмы и сценарии

- Кеширование на реверсивном прокси: ускоряем выдачу контента

- Защита на уровне сервера: waf, tls-termination и rate limiting

- Сценарии применения: реальные кейсы и архитектурные решения

- Интеграция с инструментами наблюдаемости и логирования

- Практические советы по настройке и эксплуатации

- Архитектурные паттерны: когда использовать edge proxy, когда internal proxy

- Чек-лист готовности: перед запуском в боевую эксплуатацию

- Тонкости и подводные камни: о чём нужно помнить

- Коротко о вариантах по и облачных решениях

- Заключение: реверсивный прокси как стратегическое решение в 2025

Введение: зачем нам реверсивный прокси в 2025 году

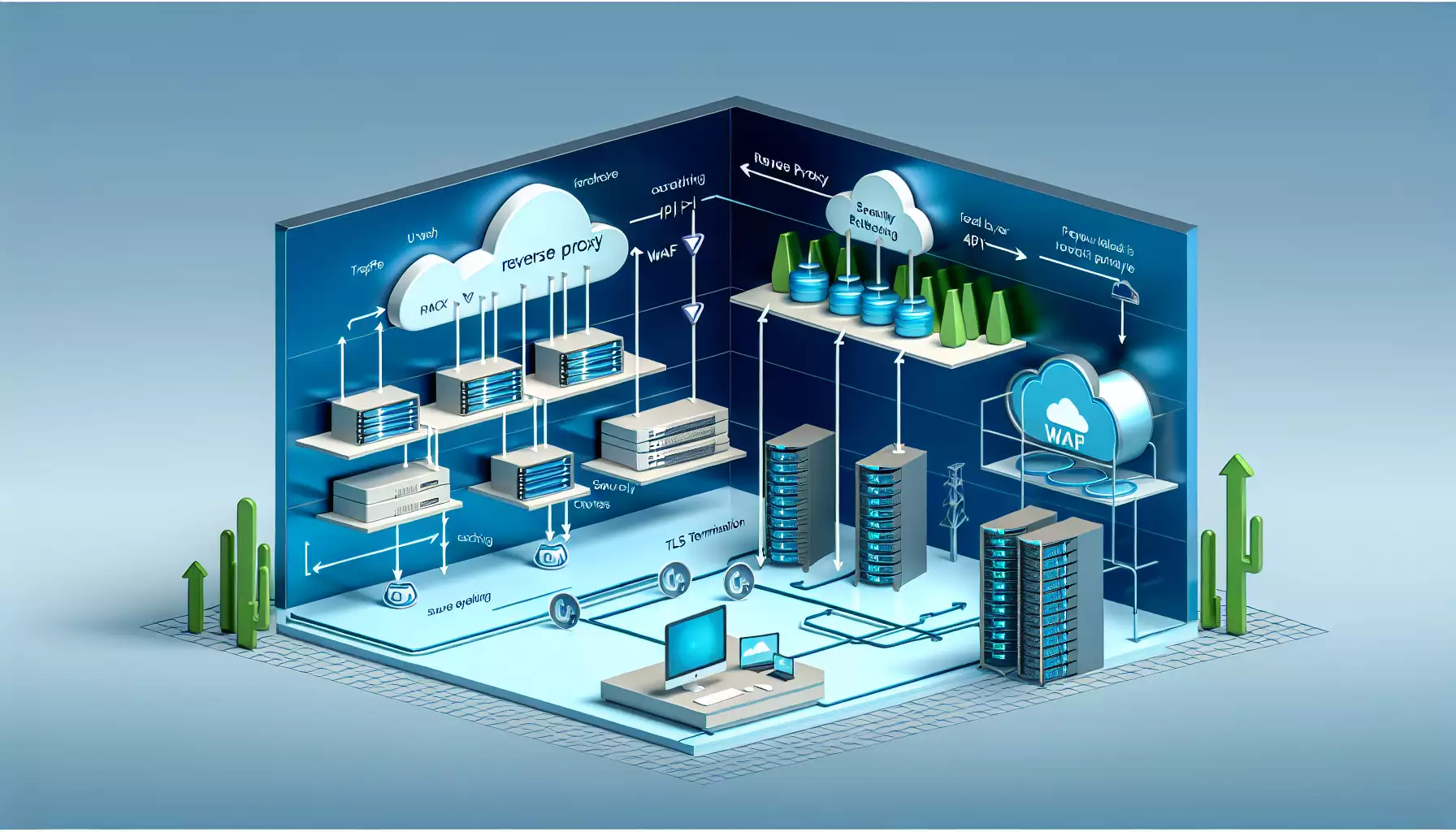

Представьте реверсивный прокси как швейцара у входа в большой офисный комплекс: он встречает гостей, удостоверяется в их правах, направляет по этажам, задерживает лишние пакеты и сообщает охране о подозрительных посетителях. В 2025 году, когда корпоративные сети становятся всё более распределёнными и хостятся в гибридных облаках, роль обратного прокси только растёт. Я расскажу просто, по-человечески и с реальными картинками в голове, как реверсивные прокси помогают балансировать нагрузку, кешировать контент и защищать серверы от внешних угроз.

Как работает обратный прокси: базовые принципы

Реверсивный прокси принимает запросы от клиентов и от своего имени общается с внутренними серверами. Клиенты не знают внутренней структуры, они видят только прокси. Это похоже на ресепшн, который принимает звонки и перенаправляет их нужному сотруднику. Технически прокси может выполнять HTTPS-терминацию, манипулировать HTTP-заголовками, маршрутизировать запросы по URL и URL-парам, применять политики кеширования и безопасности, а также собирать метрики и логировать трафик для последующего анализа.

Ключевые функции, которые реализуют современные реверсивные прокси: TLS-termination, проверка аутентификационных токенов, балансировка нагрузки, кеширование статического и динамического контента, сжатие ответов, дедупликация запросов, rate limiting и интеграция с WAF и системами обнаружения вторжений. В 2025 году все это стало стандартом для корпоративных архитектур.

Балансировка нагрузки: алгоритмы и сценарии

Балансировка нагрузки — одна из базовых и самых ценных функций реверсивного прокси. Но что это значит на практике? В двух словах: равномерно распределять работу между доступными серверами, чтобы ни один из них не перегружался и чтобы пользователи получали предсказуемую скорость отклика.

Простые алгоритмы: round-robin и least connections

Round-robin — как раздача билетов: следующий сервер в списке получает следующий запрос. Простота и предсказуемость делают этот метод популярным для однотипных бэкендов. Least connections распределяет запрос к серверу с наименьшим числом активных соединений, что полезно для сессий с долгой работающей нагрузкой.

Умные алгоритмы: weighted, least response time, hash и пэры

Weighted algorithms позволяют учитывать различия в мощности серверов: более мощный сервер получает больше трафика. Least response time выбирает сервер с наименьшей средней задержкой — полезно при гетерогенных сетях и внешней зависимости. Hash-based routing или consistent hashing помогает направлять одних и тех же пользователей на одни и те же узлы (полезно для кеша и сессий). Пэры (peer-aware) используют информацию от соседних прокси в кластере, чтобы оптимально распределять нагрузку.

Sticky sessions и их цена

Иногда нужно, чтобы сессия пользователя оставалась на одном сервере — например, когда сессии сохраняются в памяти, а не в общем хранилище. Sticky sessions решают эту задачу, но уменьшают гибкость балансировки и усложняют масштабирование. В 2025 году лучше проектировать приложения так, чтобы сессии были stateless или храниться в распределённом хранилище, но когда это невозможно, sticky session — рабочий инструмент.

Здоровье бэкендов: health checks и автоматическое исключение

Надёжная балансировка требует регулярной проверки состояния серверов: ответы на конкретные URL, анализ времени отклика, проверка доступности базы данных. Современные прокси умеют исключать «плохие» узлы из пула автоматически и возвращать их, когда они снова здоровы. Это снижает потерю пакетов и уменьшает ручной труд администраторов.

Кеширование на реверсивном прокси: ускоряем выдачу контента

Кеширование — магический рычаг производительности. Почему? Потому что почти всегда пользователи запрашивают одни и те же ресурсы: логотипы, JS-бандлы, стили, изображения, часто встречающиеся API-ответы. Кеширование на уровне обратного прокси позволяет выдавать контент без обращения к медленным или нагруженным бэкендам.

Виды кеширования: статический и динамический

Статический кеш работает с неизменяемыми ресурсами: картинки, шрифты, статические HTML. Динамический кеширует результаты рендеринга или фрагменты страниц и API-ответы. Это сложнее, потому что нужно учитывать инвалидацию кеша и приватность данных, но выигрыш по времени отклика может быть колоссальным.

Политики кеширования: Cache-Control, ETag, stale-while-revalidate

Реверсивный прокси читает и применяет заголовки Cache-Control, Expires и ETag, но при необходимости может переопределять их. Техника stale-while-revalidate позволяет отдать устаревшую (но всё ещё приемлемую) версию контента, пока прокси асинхронно обновляет кеш. Такой подход даёт лучший UX в пиковые моменты нагрузки.

Кеширование API: когда это безопасно?

Кеширование API-ответов требует осторожности: нужно учитывать параметры запроса, аутентификацию и персонализацию. Часто кешируют GET-запросы с идемпотентным контентом и временем жизни, управляющимся заголовками. Для персонализированных ответов используют более сложные паттерны: Vary-заголовки, ключи кеша по токенам, и инвалидация по событиям приложения.

Varnish, NGINX и встроенные кеши: что выбрать?

Varnish известен своей производительностью для HTTP-кеша и гибкой VCL-логикой. NGINX предлагает встроенный proxy_cache, который легко настроить и поддерживает множество сценариев. Envoy и коммерческие решения предлагают распределённые кеши и интеграцию с сервисной сеткой. Выбор зависит от архитектуры и требований к масштабируемости: Varnish для высокопроизводительных фронтов, NGINX для универсальности и простоты, Envoy для cloud-native сред и микросервисов.

Защита на уровне сервера: WAF, TLS-termination и rate limiting

Обратный прокси — отличная точка для внедрения защиты, потому что он первым принимает весь внешний трафик. В 2025 году защита должна быть гибридной: блокировка известных угроз на прокси, совместная работа с сетевыми устройствами и мониторинг в режиме реального времени.

TLS-termination и HTTP/2, HTTP/3

Терминация TLS на прокси снимает нагрузку с бэкендов: шифрование/расшифровка уходит с серверов приложений. Прокси может также поддерживать HTTP/2 и HTTP/3 для ускорения мультиплексирования и уменьшения задержек. Обновления сертификатов через ACME/Let's Encrypt или интеграция с корпоративными PKI — стандарт в 2025 году.

WAF: правила, сигнатуры и false positives

Веб-аппликационный брандмауэр (WAF) фильтрует вредоносные запросы, блокируя инъекции, XSS и другие атаки на уровне приложения. Хорошая практика — настроить WAF в режиме мониторинга сначала, чтобы собрать статистику и минимизировать false positives, затем переходить в блокирующий режим. WAF на прокси упрощает управление правилами централизованно.

Rate limiting и IP-рейтингование

Rate limiting защищает от брутфорса и мелких DDoS-атак. Современные прокси умеют применять лимиты по IP, по токенам доступа, по заголовкам, а также распределять лимит на глобальном кластере. IP-рейтингование (reputation) позволяет заранее понизить доверие к подозрительным адресам.

Bot management и поведенческая аналитика

Боты становятся всё умнее. Для их обнаружения используют сочетание поведенческой аналитики, challenge-response (капчи, JavaScript проверки) и построение профиля клиента на основе fingerprinting и скорости запросов. Всё это можно интегрировать на уровне прокси для быстрой автоматической реакции.

Сценарии применения: реальные кейсы и архитектурные решения

Ну и самое интересное — как реверсивные прокси применяются в реальной жизни. Ниже — набор сценариев, с которыми вы, возможно, сталкиваетесь прямо сейчас или встретите их в ближайшие месяцы.

1. Ускорение сайтов за счёт кеширования и сжатия

Типичный кейс: у вас есть публичный сайт с высокой посещаемостью. Установив реверсивный прокси с кешем и сжатием (gzip или brotli), вы отдаёте статичные ресурсы из памяти, сокращаете число обращений к бэкенду и экономите трафик. В 2025 году ещё актуально применять адаптивное кеширование: кеш зависит от заголовков Accept-Encoding, от геолокации и от параметров A/B тестов.

2. Балансировка микросервисов в Kubernetes

В Kubernetes обратные прокси выступают как Ingress controllers или как sidecar-прокси в сервисной сетке. Envoy, Traefik и Kong умеют динамически обнаруживать сервисы, обновлять маршруты и интегрироваться с CI/CD. Это позволяет плавно масштабировать сервисы без ручной переписки конфигураций.

3. TLS-termination и централизованное управление сертификатами

Сертификаты удобнее держать в одном месте. Реверсивный прокси обслуживает TLS, обновляет сертификаты автоматически, и передаёт трафик незашифрованным в приватную сеть или уже в зашифрованном виде до бэкенда по внутренним сертификатам.

4. Защита API-шлюза

API часто становятся наиболее уязвимой точкой. Реверсивный прокси как API-шлюз обеспечивает аутентификацию, проверку токенов, ограничение запросов и логирование. Также он может агрегировать ответы других сервисов, уменьшив число outbound вызовов у клиента.

5. Edge-кеширование и геораспределённость

Когда аудитория разбросана по миру, прокси на границе сети (edge) кэшируют контент и обеспечивают низкую латентность. В связке с CDN прокси управляют политиками кеширования, а CDN обеспечивает глобальную доставку. В 2025 году гибридный подход — прокси + CDN — особенно актуален для мультимедийных сервисов.

6. Защита от DDoS на прикладном уровне

Сетевая защита фильтрует слепые потоки, а прокси справляется с атакой на уровне приложения: rate limiting, challenge-response, блокировка IP-диапазонов и автоматические правила. Важная практика — выявление аномалий и автоматическая гормональная реакция: замедление ответов, включение кеширования выявленных запросов, и уведомление операторов.

Интеграция с инструментами наблюдаемости и логирования

Ни одна система безопасности не работает без мониторинга. Реверсивный прокси должен генерировать метрики, логи и трассировки: количество запросов, ошибки 5xx, latency, размер ответов, cache hit/miss и т.д. Эти данные подаются в SIEM, Prometheus, Grafana и APM-инструменты.

Что логировать и зачем

Логи доступа помогают понять поведение пользователей и атакующих. Логи ошибок дают информацию о сбоях в бэкендах. Логи WAF показывают попытки атак. Трассировка запроса от прокси до бэкенда помогает отладить задержки. Все это нужно централизовать и анализировать автоматизированными правилами.

Метрики, которые стоит отслеживать

- requests per second и concurrent connections;

- average и P95/P99 latency;

- cache hit ratio;

- rate of 4xx/5xx ошибок;

- количество блокировок WAF и rate limiting событий;

- использование CPU/Memory на прокси.

Практические советы по настройке и эксплуатации

Вот честный и практический набор советов, которые я бы дал командам в 2025 году, чтобы реверсивный прокси работал эффективно и не создавал бутылочных горлышек.

1. Начинайте с простого, разворачивайте постепенно

Не пытайтесь сразу настроить десятки правил WAF, кеширование и сложные маршруты. Включите базовую балансировку, TLS и логирование, соберите метрики и добавляйте функции по мере необходимости.

2. Отдельный кластер прокси для публичного трафика

Разделение публичного и внутреннего трафика уменьшает риски. Публичный кластер прокси фокусируется на защите и масштабировании, внутренний — на доступности и наблюдаемости.

3. Тестируйте правила безопасности на staging

Перед переводом WAF в блокирующий режим сначала собирайте метрики в режиме мониторинга, корректируйте правила и только затем включайте блокировку. Это спасёт от случайных блокировок легитимных пользователей.

4. План инвалидации кеша и цепочки обновлений

Кеш — это сила, но без правильной инвалидации он может выдавать устаревший контент. Настройте вебхуки, события CI/CD или ручные команды для инвалидации кеша при релизе.

5. Обеспечьте автоматическое масштабирование и резервирование

Прокси — критический компонент. Обеспечьте горизонтальное масштабирование, health checks, автоматическое восстановление и резервные наборы конфигураций. Проверьте процедуру восстановления и failover в реальной нагрузке.

6. Документируйте конфигурации и правила

Когда у тебя десятки правил и шаблонов кеша, без нормальной документации быстро наступает хаос. Документируйте почему правило введено, кто ответственен и как тестировать изменения.

Архитектурные паттерны: когда использовать edge proxy, когда internal proxy

Разделение ролей прокси в архитектуре помогает управлять рисками и масштабировать сервисы. Edge proxy отвечает за трафик из интернета: CDN-интеграция, TLS, WAF, rate limiting. Internal proxy работает внутри периметра: маршрутизация микросервисов, policy enforcement и observation.

Паттерн «Single Entry Point»

Один наружный прокси перед всеми сервисами — просто и удобно для управления сертификатами и правил безопасности. Минус — единая точка отказа, если не обеспечить HA и репликацию.

Паттерн «Multi-Tier Proxy»

Несколько уровней прокси: edge для защиты и кеша, внутренний для балансировки микросервисов и sidecar-прокси для сервисной сетки. Такой подход даёт гибкость и разделение ответственности.

Паттерн «Service Mesh + External Proxy»

В сервисной сетке sidecar-прокси (например, Envoy) обеспечивают межсервисную безопасность и телеметрию, а внешний реверсивный прокси занимается TLS-termination и защитой на границе. Это современный и удобный подход для больших распределённых систем.

Чек-лист готовности: перед запуском в боевую эксплуатацию

Ниже — практический чек-лист, который можно пройти перед запуском реверсивного прокси в продакшн. Это простой список, но он сохраняет вам ночи спокойного сна.

- Настроена TLS-терминация и автоматическое обновление сертификатов;

- Включены health checks для бэкендов;

- Проверена политика кеширования и механизм инвалидации;

- WAF настроен и протестирован в режиме мониторинга;

- Внедрены rate limiting и защита от брутфорса;

- Налажены метрики и централизованные логи в SIEM/Prometheus;

- Обеспечено горизонтальное масштабирование и отказоустойчивость;

- Проведено тестирование в режиме реальной нагрузки и сценариев отказа;

- Документированы правила, ответственные и процедуры восстановления.

Тонкости и подводные камни: о чём нужно помнить

Даже с хорошей архитектурой можно допустить ошибки. Вот несколько моментов, которые часто упускают.

Избыточная надёжность без мониторинга — это миф

Если у вас настроено масштабирование, но отсутствует наблюдаемость, вы не поймёте причины проблем. Метрики и алерты нужны не для красоты, а для своевременного реагирования.

Кеширование персонализированного контента — рискованно

Если кешировать персонализированные страницы некорректно, пользователи увидят чужие данные. Всегда проверяйте Vary-заголовки и уникальные ключи кеша по сессиям или токенам.

Неправильные правила WAF убивают UX

Слишком агрессивный WAF может блокировать легитимные действия. Проверяйте и корректируйте правила на staging, используйте белые списки и адаптивные политики.

Сжатие дешифруется дорого для старых серверов

Более слабые или старые бэкенды могут страдать от шифрования/расшифровки. TLS-termination на прокси решает проблему, но шифрование внутри сети остаётся важным для безопасности.

Коротко о вариантах ПО и облачных решениях

Выбор между NGINX, HAProxy, Varnish, Envoy, коммерческими шлюзами и облачными провайдерами зависит от требований к масштабированию, гибкости и интеграции. NGINX — универсален, HAProxy — надёжен для L4/L7, Varnish — для кеша, Envoy — для cloud-native и сервис-меш. Коммерческие шлюзы часто интегрированы с платформами безопасности и предлагают удобный UI и набор готовых правил.

В облаке провайдеры предлагают управляемые балансировщики и WAF, которые сокращают операционные усилия, но требуют доверия к провайдеру и могут быть дороже при высоких нагрузках.

Заключение: реверсивный прокси как стратегическое решение в 2025

Реверсивный прокси — не просто промежуточный слой. Это стратегический узел, который повышает производительность, делает архитектуру гибче и защищает приложения на границе сети. В 2025 году, с ростом распределённых архитектур и усложнением угроз, правильно настроенный прокси — обязательный элемент корпоративной безопасности и оптимизации. Начните с простых шагов: TLS-termination, базовая балансировка и логирование, затем постепенно добавляйте кеширование, WAF и интеграцию с системой наблюдаемости. Документируйте решения, тестируйте в staging и держите руку на пульсе метрик — тогда прокси будет работать как надёжный швейцар у входа в ваш цифровой офис.

FAQ

- Что лучше для кеша: Varnish или NGINX?

Varnish отлично подходит для высокопроизводительного кеширования HTTP-ответов и даёт большую гибкость через VCL. NGINX проще интегрировать и использовать как универсальное решение, если нужно одновременно и балансировать и кешировать.

- Можно ли доверять WAF полностью?

Нет, WAF — важная часть защиты, но он не всесилен. Лучше использовать WAF в сочетании с rate limiting, сетевой защитой и мониторингом инцидентов.

- Как поступать с персонализированными API при кешировании?

Кешируйте только те части, которые не содержат персональных данных, или используйте ключи кеша с учётом идентификаторов пользователей и Vary-заголовков. Инвалидация по событиям приложения — полезный инструмент.

- Нужен ли отдельный кластер прокси для edge?

Да, разделение edge и internal прокси повышает безопасность и управляемость, особенно если у вас гибридное или мультиоблачное решение.

- Как тестировать правила WAF перед включением в продакшн?

Включите WAF в режиме мониторинга на staging и ограниченном трафике, соберите логи и проанализируйте false positives, затем корректируйте правила и постепенно переводите в блокирующий режим.