Техническое SEO для e-commerce: оптимизация каталогов и фасетной навигации

Содержание статьи

- Введение: зачем техническое seo для e-commerce и почему это важно

- Что такое фасетная навигация и почему она вызывает проблемы

- Дублированный контент: как он возникает в каталоге

- Пагинация: как её правильно показать поисковикам

- Каноникализация: как и когда использовать rel=canonical

- Использование noindex: когда закрывать страницы от индексации

- Работа с url-параметрами: правильно сообщаем поисковикам

- Ajax и клиенто-ориентированные фильтры: плюсы и минусы для seo

- Карта сайта (sitemap) и её роль в больших каталогах

- Внутренняя перелинковка: как направлять «вес» к важным страницам

- Мета-теги и заголовки: как избежать похожести и спама

- Качественные описания товаров: почему это не только для пользователя

- Структурированные данные (schema.org) для e-commerce

- Файлы robots.txt: правила и подводные камни

- Редиректы: как управлять устаревшими товарами и url

- Кэширование и производительность: технический seo-основы

- Мобильная оптимизация: обязательное условие

- Локализация и hreflang в международном e-commerce

- Мониторинг и аналитика: что и как отслеживать

- Автоматизация и правила для больших каталогов

- Контентные стратегии для больших каталогов: как масштабировать качество

- Кейс: типичная оптимизация большого каталога (пошагово)

- Чеклист технической оптимизации для e-commerce (подытожим)

- Частые ошибки, которых можно избежать

- Когда привлекать seo-специалиста и разработчика

- Заключение: системный подход и небольшие шаги — ключ к успеху

- Дополнительные ресурсы и следующий шаг

Введение: зачем техническое SEO для e-commerce и почему это важно

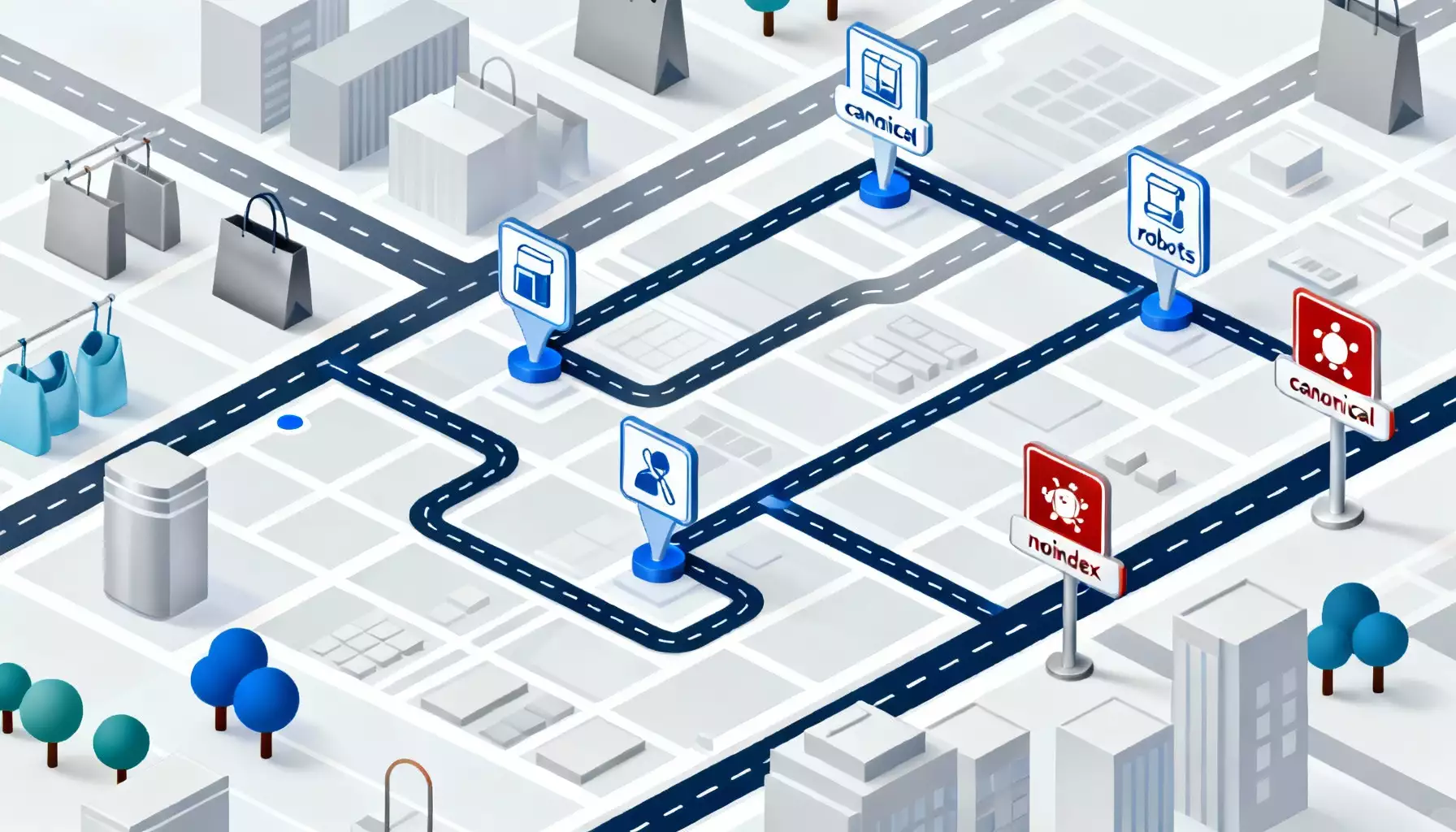

Представь себе магазин, в котором товары разложены по полкам, но навигация запутанная: посетители ходят вокруг, не находят нужное, уходят. Так же ощущает себя поисковая система, когда попадает на плохо организованный каталог интернет-магазина. Техническое SEO — это не только про скорость и мобильную адаптацию, это про то, чтобы «сказать» поисковикам, какие страницы важны, а какие — технические шумы. В e-commerce это особенно критично, потому что на кону тысячи товаров, десятки фильтров и десятки тысяч URL, которые могут породить дубли, пустые страницы и бессмысленные индексации.

В этой статье я разберу ключевые технические проблемы, с которыми сталкиваются магазины: фасетная навигация, дублированный контент, пагинация, фильтры, каноникализация и директивы noindex. Будет много практических советов, примеров и чеклистов, которые можно применить прямо сейчас. Я говорю простым языком без занудных определений, но с понятными аналогиями и примерами из реальной практики.

Что такое фасетная навигация и почему она вызывает проблемы

Фасетная навигация — это система фильтров, которая помогает покупателям сузить выбор: по цвету, размеру, цене, бренду и другим характеристикам. Звучит как спасение, правда? Но с технической точки зрения фасеты создают лавину URL: каждая комбинация двух-трёх фильтров может порождать уникальный URL, и число их растёт комбинаторно. Это как если бы в супермаркете каждой кассе дали отдельную витрину — понятность пропадает.

Поисковые роботы любят порядок. Когда они видят тысячи похожих страниц с минимальными отличиями, возникает несколько рисков: индексирование бесполезных страниц, разбавление веса основных товарных страниц и появление дублей. Итог — страницы, которые важны для бизнеса, не получают нужного внимания от поисковых систем, а бюджет краулинга тратится на фильтры и пустые каталоги.

Примеры проблем фасетов в реальной жизни

Представь каталог «Обувь» с фильтрами «цвет», «размер» и «материал». Без ограничений система может сгенерировать URL для «красные кожаные туфли размер 38», «красные кожаные туфли размер 39», «черные замшевые ботинки размер 38» и так далее. Многие из этих страниц практически идентичны по содержанию: те же описания, похожие мета-теги, те же категории. С точки зрения SEO это — катастрофа.

Дублированный контент: как он возникает в каталоге

Дублированный контент в e-commerce — это не редкость. Он возникает из-за сортировки, фильтрации, пагинации, различий в URL-параметрах (например, ?sort=price_asc или ?view=list), а также из-за однотипных описаний товаров от поставщиков. Иногда дубли создаются непреднамеренно: сайт может открывать один и тот же товар под несколькими URL, или динамически подтягивать карточки в разных блоках.

Почему дубли — это плохо? Во-первых, поисковики вынуждены выбирать, какую версию показать. Во-вторых, внутренняя «сила» (link equity) рассеивается по нескольким копиям. В-третьих, это лишняя нагрузка на сервер и нездоровое потребление бюджета краулинга. В итоге — меньше трафика и конверсий.

Типичные источники дублированного контента

- Параметры в URL (фильтры, сортировка, сессии).

- Пагинация — страницы 1, 2, 3 и т.д. с одинаковыми по сути блоками товаров.

- Несколько версий одной и той же карточки товара (например, с разными кампаниями, UTM-метками, трекингом).

- Копии описаний от поставщиков без уникализации.

- Страницы с похожими мета-тегами и H1, отличающиеся лишь сортировкой.

Пагинация: как её правильно показать поисковикам

Пагинация — это типичный механизм для разбивки длинных списков на удобные кусочки. Но если её не оптимизировать, поисковик будет краулить страницы 1–100 и тратить на это бюджет, а страница с полной ценностью — теряться. Раньше использовали rel=prev/next, но Google заявил, что больше не использует эти атрибуты как сигнал. Что делать? Есть несколько стратегий, и лучшая зависит от структуры каталога и бизнеса.

Стратегии работы с пагинацией

- Индексировать только основную страницу категории — полезно, когда товары динамически меняются и страницы пагинации не содержат уникального контента. Можно поставить noindex на страницы пагинации, оставить каноническую на страницу 1 и позволить поисковику индексировать основную категорию.

- Индексировать все страницы, если у каждой есть ценная уникальная информация — годится, когда каждая страница 2, 3 и т.д. содержит уникальные подкатегории, обзоры или важные точки входа для пользователей. В этом случае стоит оптимизировать title и meta description, чтобы они были уникальными и отражали содержимое конкретной страницы.

- Применение каноникализации — можно канонизировать страницы пагинации на главную страницу категории или на саму себя в зависимости от стратегии. Важно правильно настроить rel=canonical, чтобы не потерять трафик.

Выбор зависит от размера каталога и пользовательского опыта. Я рекомендую протестировать и смотреть результаты: какие страницы приносят трафик, какие — нет. Часто гибридный подход работает лучше: ключевые категории индексируем, тонкие комбинированные фильтры — закрываем от индексации.

Каноникализация: как и когда использовать rel=canonical

Rel=canonical — один из самых мощных инструментов в арсенале технаря. Он позволяет указать поисковику, какая версия страницы является предпочтительной. Но каноникализация — не волшебная палочка: она работает как рекомендация, а не как директива, и поисковики могут её игнорировать, если встречают сигналы несоответствия (например, контент двух страниц сильно отличается от канонической).

Правила корректной каноникализации

- Каноникальная ссылка должна указывать на релевантную и доступную страницу без редиректов.

- Всегда указывайте абсолютный URL в rel=canonical.

- Не канонизируйте разнообразные паттерны фильтрации на одну страницу, если контент действительно различается.

- Проверяйте ответ сервера — каноника не должна вести на 404 или 301.

- Синхронизируйте каноникализацию с картой сайта: включайте в sitemap только канонические URL.

Пример: если у вас есть страницы с параметрами ?color=red и ?color=blue, и обе являются низкоценностными вариантами каталога, можно канонизировать их на основную страницу категории. Но если каждая страница содержит уникальные подборки или отзывы, тогда каноникать не стоит.

Использование noindex: когда закрывать страницы от индексации

Noindex — это директива, которая говорит поисковой системе не показывать страницу в выдаче. Но важно помнить: noindex не экономит краулинг, пока страница доступна; чтобы исключить её полностью из индекса, нужно, чтобы поисковик заметил директиву и удалил страницу. Также noindex не передаёт link equity, поэтому если вы закрываете страницу, подумайте, куда направлять внутренние ссылки.

Какие страницы стоит пометить как noindex

- Страницы пагинации, если вы не хотите, чтобы роботы индексировали страницы 2, 3 и т.д.

- Сочетания фильтров, которые генерируют тысячи низкоценностных URL.

- Страницы результата поиска внутри сайта (внутренний поиск).

- Копии товарных карточек с параметрами трекинга.

- Страницы профилей пользователей, корзины, чекаут (они не должны быть в выдаче).

Важно: помечая страницу noindex, подумайте о внутренней ссылочной структуре. Если внутренняя система ссылается на такие страницы как на важные, то закрытие их от индексации может привести к потере силы ссылок. Часто лучше перенаправлять внутренние ссылки на канонические версии.

Работа с URL-параметрами: правильно сообщаем поисковикам

Параметры в URL могут быть джунглем. Они несут трекинг, сортировку, фильтрацию и сессии. Если не управлять ими, можно случайно допустить индексирование лишних вариантов. У поисковых систем есть инструменты для управления параметрами (например, Google Search Console позволял указывать, как обрабатывать параметры, но в последних годах эти функции меняют свои интерфейсы), однако чаще всего решение нужно принимать на уровне сайта: структурировать URL, использовать каноникализацию, или закрывать бессмысленные страницы через robots или noindex.

Практические рекомендации по параметрам

- Используйте человекочитаемые URL для основных категорий и товаров: /catalog/obuv/kedy, а параметры оставляйте для фильтров, если они имеют смысл.

- Старайтесь избегать создания отдельных страниц для каждой комбинации параметров; вместо этого применяйте AJAX-фильтры, которые не генерируют новый URL (или используют pushState аккуратно).

- Если параметры всё же приводят к уникальному контенту, убедитесь, что каждая такая версия имеет оптимизированные мета-данные и внутренние ссылки.

- Параметры для аналитики (utm, gclid и т.п.) должны быть игнорированы для индексации — используйте каноникализацию на чистый URL.

AJAX и клиенто-ориентированные фильтры: плюсы и минусы для SEO

AJAX-фильтры дают отличную UX: пользователи быстро видят результат фильтрации без перезагрузки страницы. С точки зрения SEO это также может быть плюсом, потому что не рождаются тысячи статичных URL. Но и здесь есть подводные камни: если вы хотите, чтобы отдельные комбинации фильтров индексировались (например, бренд + категория), AJAX не даст этому сразу ход, и потребуется реализация прогрессивной очистки контента и дружественных URL.

Я рекомендую комбинировать: ключевые фильтры (бренд, категория, тип товара) — с отдельными SEO-URL, а остальные параметры (например, цвет, материал) — реализовать через AJAX без создания новых URL. Это баланс между UX и поисковой оптимизацией.

Карта сайта (sitemap) и её роль в больших каталогах

Sitemap — это как список фаворитов, который вы передаёте поисковикам. Для больших каталогов важно поддерживать несколько карт: основную для категорий и товаров, отдельные карты для изображений и видео, а также разбивку карт по приоритетам. Большие магазины могут генерировать динамические sitemap.xml, которые показывают только канонические URL и обновляются по мере добавления товаров.

Рекомендации по карте сайта

- Включайте в sitemap только канонические URL.

- Разбивайте sitemap по типам контента (категории, товары, блог).

- Ограничивайте одну карту 50 000 URL, используйте индекс-карту для объединения нескольких файлов.

- Указывайте актуальные lastmod, особенно если карточки часто обновляются (цена, наличие).

- Не добавляйте в sitemap URL с noindex или те, которые канонизированы на другие страницы.

Внутренняя перелинковка: как направлять «вес» к важным страницам

Перелинковка — это внутренний маршрут, по которому сила ссылок (link equity) распределяется по сайту. В больших каталогах важно, чтобы топовые товарные и категорийные страницы получали достаточное внимание. Представь, что сайт — это город, и внутренняя перелинковка — это дороги. Если к важным местам ведут только грунтовки, то посетители и поисковые роботы будут приходить реже.

Практические приёмы перелинковки

- Создавайте тематические блоки «Похожие товары» и «С этим товаром покупают», чтобы распределять ссылочный вес и улучшать юзабилити.

- Используйте хлебные крошки — они важны как для пользователей, так и для поисковых систем, и помогают строить иерархию страниц.

- Оптимизируйте меню: не перегружайте его ссылками, но убедитесь, что важные разделы доступны из главного навигационного блока.

- Скрытые ссылки (например, в фильтрах) не передают ценность так же, как обычные, поэтому не полагайтесь только на них для передачи веса.

Мета-теги и заголовки: как избежать похожести и спама

Мета-теги и H1 являются сигнальными факторами для поисковиков. В интернет-магазинах часто используют шаблонные заголовки: «Кроссовки Nike — купить» для сотен страниц, меняя только бренд. Такие шаблоны не добавляют уникальности и могут привести к тому, что страницы начинают конкурировать между собой в выдаче. Поэтому важно балансировать между автоматизацией (когда много товаров) и уникализацией ключевых страниц.

Как писать мета-заголовки и H1

- Для категорий используйте комбинацию ключа и УТП: «Кроссовки для бега — амортизация, доставка 1 день».

- Товарные страницы требуют уникальности: добавьте модель, основную характеристику и преимущество.

- Избегайте дублирующихся заголовков и мета-описаний в пределах сайта.

- Автоматизация допустима, но добавьте вариативность: шаблоны с вставкой уникальной характеристики, например, цвет или материал.

Качественные описания товаров: почему это не только для пользователя

Копипаста от поставщиков экономит время, но влечёт за собой проблемы: дубли, низкая конверсия и плохой UX. Уникальные описания повышают шансы на ранжирование, улучшают поведенческие факторы и помогают избежать наказаний за дубли. Подходите к описаниям как к рассказу о продукте: что он решает, для кого, и какие есть доказательства (отзывы, сертификаты).

Даже если у вас тысячи товаров, можно оптимизировать процесс: шаблоны описаний с обязательными полями (особенности, материал, преимущества), комбинирование автоматического и ручного контента для приоритетных SKU, а также использование структурированных данных для товара.

Структурированные данные (schema.org) для e-commerce

Структурированные данные помогают поисковикам понять, что находится на странице: цена, наличие, рейтинг, отзывы. В e-commerce это особенно важно: увеличивает шансы на отображение расширенных сниппетов, что повышает CTR. Schema.org предоставляет типы Product, Offer, Review и т.д.

Советы по внедрению структурированных данных

- Добавляйте Product и Offer на карточки товаров с актуальной ценой и наличием.

- Подключайте Review и AggregateRating, если есть отзывы пользователей.

- Обновляйте структурированные данные при изменении цены и статуса товара.

- Проверяйте JSON-LD через инструменты для тестирования и Search Console.

Файлы robots.txt: правила и подводные камни

Robots.txt — это инструкция для поисковых роботов, что можно краулить, а что нет. Но важно помнить: запрет через robots.txt не мешает индексации URL, если на них есть ссылки с других сайтов; он только запрещает краулинг. Поэтому для исключения из индекса нужно использовать noindex или удалять страницы через правильные методы.

Что можно и чего нельзя блокировать через robots.txt

- Блокируйте ресурсы, которые не должны краулиться (скрипты, служебные страницы, админ-панели).

- Не блокируйте CSS и JS без необходимости — это ухудшит рендеринг страниц поисковиками.

- Не используйте robots.txt чтобы скрывать страницы от индексации — это не заменит meta robots noindex.

- Проверяйте правила перед деплоем: один неверный Disallow может закрыть весь сайт.

Редиректы: как управлять устаревшими товарами и URL

Редиректы — это инструмент управления URL при удалении или перемещении товаров. Использовать 301 редирект правильно — значит сохранять ссылочный вес и давать пользователю полезную альтернативу. Неправильные редиректы приводят к потере трафика и путанице поисковых систем.

Стратегии редиректов для товаров

- Если товар полностью удалён и аналогов нет — верните 410 (Gone) для быстрого удаления из индекса.

- Если есть близкие аналоги или заменители — 301 редирект с удалённого SKU на наиболее релевантный продукт или категорию.

- Не делайте каскадных редиректов: 301→301→301 увеличивает задержки и снижает эффективность.

Кэширование и производительность: технический SEO-основы

Скорость сайта влияет на позиции и на поведение пользователей. В e-commerce задержки приводят к потерям в конверсии и ухудшению индексации. Оптимизация изображений, lazy-loading, CDN, минимизация запросов и правильные заголовки кэширования — всё это базовые задачи для магазина.

Приоритетные шаги по ускорению

- Оптимизируйте и форматируйте изображения (WebP, адаптивные размеры).

- Включите серверное кэширование и используйте CDN для статики.

- Минимизируйте JavaScript и CSS, загружайте не критические скрипты асинхронно.

- Используйте preconnect и preload для ключевых ресурсов.

Мобильная оптимизация: обязательное условие

Большая часть трафика в 2025 году приходит с мобильных устройств. Мобильная версия сайта должна быть быстрой, удобной и функциональной. Google использует mobile-first индексацию, поэтому ошибки на мобильной версии напрямую влияют на ранжирование.

На что обратить внимание

- UX фильтров на мобильных — удобство выбора, сохраняемый контекст, очищение фильтров.

- Размеры кнопок и полей, адаптивные изображения и отсутствие всплывающих элементов, закрывающих контент.

- Тестирование скорости и рендеринга на реальных устройствах.

Локализация и hreflang в международном e-commerce

Если вы продаёте в нескольких странах или на нескольких языках, hreflang — ваш друг. Он помогает указать, какая версия страницы предназначена для какого языка или региона, предотвращая проблематику дублированного контента между языковыми версиями.

Правила применения hreflang

- Каждая языковая версия должна указывать на все другие версии через hreflang, включая саму себя.

- Используйте правильные коды (например, ru-RU, en-GB).

- Не смешивайте региональные и языковые стратегии без чёткой структуры URL.

Мониторинг и аналитика: что и как отслеживать

Технический SEO — это не разовая правка, это постоянный процесс. Следите за метриками: индексируемые страницы, ошибки 4xx/5xx, скорость загрузки, канонические конфликты, лог-файлы и распределение краулинга. Инструменты вроде Google Search Console, Bing Webmaster Tools, а также анализ логов сервера — необходимы для понимания, куда идут роботы и что они видят.

Основные метрики для контроля

- Число проиндексированных страниц и их распределение по типам.

- Ошибки индексации и проблемы с каноническими URL.

- Трафик и позиции по ключевым категориям и SKU.

- Логи краулинга — какие URL чаще посещаются ботами и где тратится бюджет.

Автоматизация и правила для больших каталогов

Управлять вручную тысячами товаров — невозможно. Автоматизация — ключ к стабильности: динамические шаблоны мета-тегов, правила каноникализации, генерация sitemap, регулярные отчёты об ошибках. Но автоматизация должна быть умной: она не заменит ручную оптимизацию для приоритетных страниц.

Создайте уровни приоритетов: VIP-товары (большое маржинальное значение), второстепенные товары и устаревшие позиции. Для каждой группы задайте свои правила индексации, описаний и обновлений.

Контентные стратегии для больших каталогов: как масштабировать качество

Контент — это не только описания. Это гайды, обзоры, сравнения, обзёрные страницы категорий с уникальными текстами и блоками. Стратегия должна включать генерацию контента для ключевых категорий и сезонных продуктов. Для остального — гибрид автоматизированных шаблонов и минимальных уникальных вставок.

Идеи контента, которые работают

- Руководства по выбору товара: «Как выбрать кроссовки для бега».

- Обзоры и сравнения: «Лучшие смартфоны 2025 года в ценовой категории до 30000 руб.».

- Блоги с кейсами использования и лайфхаками.

- Видео и инструкции по использованию товаров.

Кейс: типичная оптимизация большого каталога (пошагово)

Давай разберём гипотетический случай: магазин электроники с 50 000 SKU. Проблема: краулер тратит ресурс на тысячи вариаций фильтров, много дублей и плохие позиции по ключевым категориям. Что делаем?

- Анализ логов краулинга: определяем, какие URL чаще посещаются ботами и какие тратят бюджет зря.

- Сегментируем URL по типам: товарные страницы, категории, фильтры, пагинация.

- Внедряем правила: noindex для внутренних поисковых страниц и комбинированных фильтров, каноникализация на основные категории для низкоценностных параметров.

- Оптимизируем sitemap — оставляем только канонические URL и разбиваем по приоритету.

- Улучшаем скорость сайта: CDN, оптимизация изображений, lazy-loading.

- Проводим работу по уникализации описаний для 5 000 приоритетных SKU и автоматизируем шаблоны для остальных.

- Внедряем структурированные данные для товаров и отзывов.

- Мониторим результат и корректируем: рост индексации у ключевых страниц, сокращение ошибок, улучшение позиций и трафика.

Чеклист технической оптимизации для e-commerce (подытожим)

Вот компактный список действий, которые можно начать выполнять прямо сейчас:

- Провести аудит логов краулинга и Search Console.

- Определить приоритетные страницы и создать правило для обработки низкоценностных URL.

- Настроить rel=canonical правильно и скоординировать с sitemap.

- Пометить noindex ненужные страницы: внутренний поиск, пагинация при необходимости, служебные страницы.

- Оптимизировать мета-теги и H1, избегая дублирования.

- Уникализировать описания для приоритетных товаров.

- Внедрить структурированные данные и держать их в актуальном состоянии.

- Обеспечить мобильную скорость и UX фильтров.

- Правильно настроить редиректы и обработку удалённых товаров.

- Поддерживать актуальный sitemap и robots.txt.

Частые ошибки, которых можно избежать

Некоторые ошибки повторяются у многих магазинов. Я перечислю их, чтобы вы могли проверить своё решение:

- Каноникали на страницы, которые редиректят или 404.

- Закрытие CSS/JS в robots.txt, что мешает рендерингу.

- Индексирование тысяч фильтрованных страниц без пользы.

- Отсутствие структурированных данных или их некорректное использование.

- Каскадные редиректы и циклы редиректов.

- Плохая мобильная адаптация фильтров и картинок.

Когда привлекать SEO-специалиста и разработчика

Техническое SEO в больших интернет-магазинах требует взаимодействия бизнеса, SEO и разработки. Если у вас тысячи товаров и сложная фасетная навигация — пора привлекать минимум одного опытного SEO-специалиста и одного разработчика, который понимает архитектуру сайта и серверные ограничения. Работать в вакууме не получится: оптимизация влияет на UX, на маркетинг, на систему управления товарами (PIM) и на процессы снабжения.

Заключение: системный подход и небольшие шаги — ключ к успеху

Техническое SEO для e-commerce — это не какой-то магический набор настроек. Это системный подход к управлению каталогом, фасетной навигацией и индексируемыми страницами. Маленькие шаги приводят к большим результатам: уменьшение дублей, правильная каноникализация, грамотное использование noindex и оптимизация пагинации способны существенно улучшить видимость и конверсии.

Не пытайтесь закрыть всё одним махом. Начните с аудита, поставьте приоритеты, автоматизируйте рутинные процессы и оставьте ручной труд для VIP-продуктов. И помните: цель не в том, чтобы закрыть все страницы от индексации, а в том, чтобы поисковики видели и ценили те страницы, которые действительно приносят вашему бизнесу продажи.

Дополнительные ресурсы и следующий шаг

После прочтения этой статьи рекомендую составить план действий на 90 дней: аудит логов, корректировка robots и sitemap, настройка каноникализации, применение noindex для бессмысленных фильтров, уникализация описаний для приоритетных товаров и внедрение структурированных данных. Пошаговое выполнение этого плана принесёт ощутимые результаты за 2–3 месяца, а системная работа — устойчивая положительная динамика позиций и трафика в долгосрочной перспективе.

Короткий итог в трёх пунктах

- Определите, какие страницы действительно должны индексироваться — это основа.

- Применяйте rel=canonical и noindex осознанно, в связке с sitemap и внутренними ссылками.

- Улучшайте UX и скорость сайта — это напрямую влияет на SEO и конверсии.

Если хочется, могу подготовить чеклист конкретных технических задач под ваш магазин или пример конфигурации robots.txt и sitemap, адаптированный под размер каталога и уровень автоматизации. Но уже сейчас вы можете начать с анализа логов и списка наиболее индексационных URL — это часто даёт «быстрый выигрыш» в эффективности краулинга и видимости.