Что такое URL Slug и как сделать его SEO-дружественным

В настоящее время адреса сайтов — это не просто набор букв и цифр, а важная часть продвижения площадки в целом, повышение лояльности к ней со стороны целевой аудитории. Это то решение, которое помогает людям и поисковым системам понять, о чем страница, даже не заходя на нее. Представьте ситуацию, что вы ищете в интернете статью о маркетинге и видите ссылку вроде https://example.com/?p=12345. Она выглядит как пустой набор букв, символов, цифр, которые ничего вам не говорят. Захотите ли вы перейти по такой ссылке? Скорее всего нет так как не понимаете, что вы увидите на этой странице. При этом рядом вы видите другой URL-адрес https://example.com/blog/kak-uluchshit-sayt-dlya-poiska. Даже беглого взгляда на название будет достаточно для того, чтобы понять, о чем именно будет здесь идти речь. И с высокой долей вероятности вы перейдете именно на эту страницу.

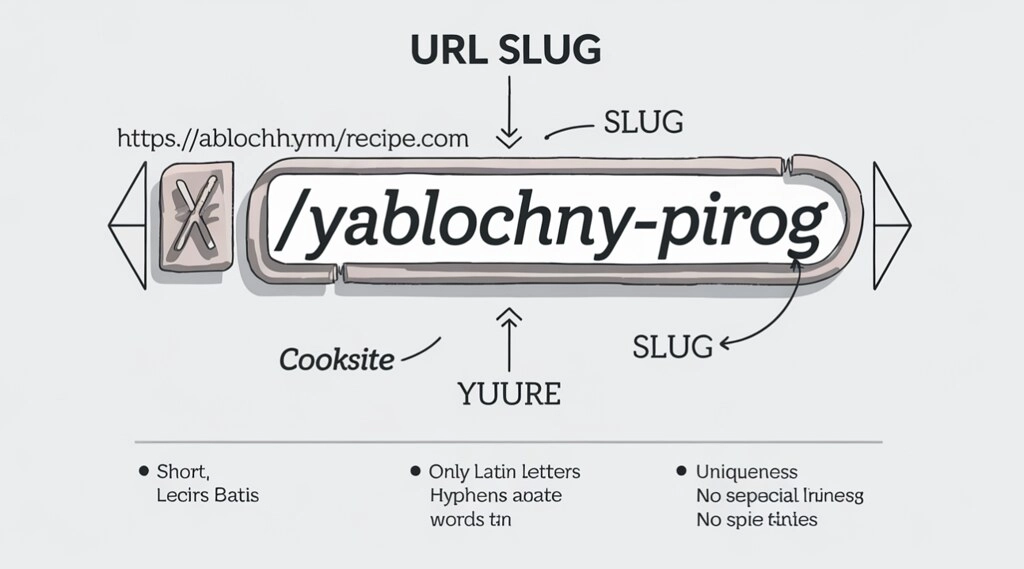

На этом примере мы показали то, что представляет собой URL Slug или как его еще часто называют просто слаг — простая часть адреса страницы, которая может сделать ваш сайт более заметным в поиске и выделить его на фоне аналогов. Здесь мы говорим о короткой фразе, что будет дописываться к адресу сайта после последнего знака «/». Она показывает на то, чему именно посвящена эта страница, и делает ссылку более понятной как для аудитории, так и для поисковых ботов. Слаг в своем большинстве состоит из простых слов, написанных маленькими буквами и разделенных между собой дефисами и без лишних символов.

Зачем это нужно? Во-первых, такой слаг помогает поисковикам вроде Google и Яндекса лучше понять страницу и показать ее выше в результатах поиска в том случае, если слова в нем подходят к запросам людей. Во-вторых, он окажется действительно удобным и информативным для посетителей: ссылка легко читается, запоминается и чаще кликается. Статистика показывает, что подобное решение на практике увеличивает число переходов не менее, чем на 20-30%. В-третьих, правильный URL Slug упрощает работу сайта, избегает путаницы с похожими страницами и помогает поисковикам быстрее их найти.

И одна из наиболее важных задач в данном вопросе будет состоять в том, чтобы создать такой слаг, который окажется максимально корректным и информативным. В нем мне должно быть русских букв, лишних слов, ведь подобное решение может сделать вашу страницу менее видимой в результатах поисковой выдачи. Чтобы подобного не произошло, необходимо глубоко разобраться в данном вопросе. Именно этому и будет посвящен наш сегодняшний материал. В частности, сейчас познакомимся с тем, что же представляет собой URL Slug, и какую роль он играет в SEO.

Распишем подробно те инструменты, что помогут выявить существующие ошибки при формировании URL Slug. Выделим ряд проблем, с которыми чаще всего сталкиваются пользователи на этапе написание слага. Приведем ряд практических рекомендаций, что помогут вам оптимизировать адреса страничек собственного сайта. Представленная информация позволит вам создать действительно качественный URL Slug, удовлетворяющий запросам и обычных пользователей, и поисковых ботов.

Также предлагаем изучить материал «Динамический URL-адрес что это такое и как его использовать».

Что такое URL Slug?

Лучше всего понять, что такое URL Slug поможет простой пример из жизни. Представьте, что вы ищете рецепт яблочного пирога в интернете. В этом случае хороший адрес страницы мог бы выглядеть так: https://mysite.com/recipes/kak-sdelat-vkusnyy-yablochnyy-pirog. Здесь слаг — это вся та часть вашего адреса, которая прописана после последнего знака «/», то есть «kak-sdelat-vkusnyy-yablochnyy-pirog». Она коротко рассказывает, о чем эта страница, и помогает сразу понять, что вас ждет после перехода на нее.

И здесь возникают вполне закономерный вопрос: почему мы не используем абсолютно весь кусочек адреса «recipes/kak-sdelat-vkusnyy-yablochnyy-pirog»? Потому что «recipes» — это просто раздел сайта, как вариант, папка с рецептами или категория в меню. Но здесь мы говорим непосредственно об URL Slug, то есть об особой метке именно для одной конкретной страницы, предусмотренной внутри раздела. Она делает адрес понятным, удобным и простым в восприятии: люди уже изначально видят, о чем будет материал, а поисковая система быстрее понимают тему и показывают страницу нужным пользователям.

Еще один пример: если у вас интернет-магазин одежды, то хороший адрес товара может быть следующим: https://shop.com/odezhda/letnyaya-futbolka-dlya-muzhchin. В данном случае слаг — это «letnyaya-futbolka-dlya-muzhchin», то есть фраза, ясно описывающая товар — летнюю футболку для мужчин. Такой подход не только упрощает поиск, но и повышает доверие со стороны аудитории и поисковых ботов: ссылка выглядит аккуратно, без лишних цифр или знаков. А это значит, что люди охотнее на нее кликнут. В итоге сайт становится удобнее для всех, а страницы чаще попадают в топ поиска.

Какую роль играет URL Slug на этапе SEO-продвижения сайта

Когда перед вами ссылка вроде https://site.com/page?id=98765, она выглядит странно и непонятно: что там за страница, можно ли ей доверять? Люди обычно не переходят по таким адресам, считаю их подозрительными. Более того, не любят их и поисковые системы, ведь им сложно изначально понять, о чем идет речь.

Гораздо лучше, если адрес выглядит так: https://site.com/blog/kak-vybrat-velosiped-dlya-goroda. Здесь сразу видно, что здесь речь идет о таком разделе сайта как блог, а сама страница посвящена выбору велосипеда для города. Такой адрес помогает и людям, и поисковикам быстро разобраться, что внутри. Это значит, что сайт будет проще найти, а страница в итоге окажется выше в результатах поисковой выдаче.

Почему это работает на практике? Здесь есть несколько аспектов, которые стоит принять во внимание:

- Понятная и логически выстроенная структура. Если адрес сайта простой, поисковики быстрее находят нужные страницы и показывают их на более высоких позициях. Например, https://shop.com/catalog/zimnie-botinki. Здесь сразу понятно, что речь о зимних ботинках в каталоге магазина.

- Ключевые запросы в адресе. Если в слаг присутствуют важные слова, как вариант «remont-smartfona», то поисковик понимает, что страница оптимально подходит для запроса «ремонт смартфона». Это помогает ей попасть в топ по нужным темам.

- Удобство для людей. Читаемый адрес вызывает доверие, его легко запомнить и переслать другу. Практика показывает, что люди чаще кликают на такие ссылки, а это значит, что сайт получает больше посетителей и планомерно продвигается в верхушку поисковой выдачи.

Надеемся теперь вы понимаете важность использования корректного URL Slug на страничках вашего сайта и знаете, что ваша площадка только выиграет от этого: она станет более заметной и удобной как для реальных пользователей, так и для ботов поисковых систем.

Для решения каких задач стоит использовать URL Slug

URL Slug — это не просто кусочек адреса сайта, а настоящий помощник для вашего сайта и его посетителей. Вот только несколько наглядных подтверждений его важности и доказательства того, какие задачи он способен решить:

- Уникально идентифицирует каждую страницу. Слаг — это своего рода имя для страницы. Например, если у вас сайт о путешествиях, адрес https://travelblog.com/italy/rome-dostoprimechatelnosti сразу говорит, что речь о достопримечательностях Рима. Такой URL Slug помогает не запутаться в похожих страницах и быстро найти нужную информацию.

- Помогает сайту оказаться выше конкурентов в результатах поисковой выдачи. Если в слаг есть нужные слова, как вариант «remont-noutbuka» для страницы о ремонте ноутбуков, поисковики понимают, что эта страница подходит для такого запроса. Это увеличивает шансы, что ваш сайт увидят больше людей.

- Делает сайт удобнее для людей. Мы уже говорили о том, что в случаях, когда адрес страницы короткий и понятный, пользователи смогут более легко и просто его запомнить или найти снова. Здесь все понятно: название https://shop.com/odezhda/zimnyaya-kurtka будет гораздо проще осознать и запомнить, чем длинную ссылку с хаотичными буквами, цифрами и знаками.

- Снижает технические ошибки. Простые слаги без лишних символов и пробелов реже вызывают проблемы у поисковых роботов. Это значит, что страницы быстрее попадают в поиск и не теряются из-за ошибок.

- Добавляет контекст и смысл. URL Slug подсказывает, о чем страница, даже если вы пока еще не открывали ее. К примеру, адрес https://recipes.com/vypechka/shokoladnyy-tort сразу говорит нам о том, что при переходе на данную страничку вы увидите рецепт шоколадного торта. При этом поисковики также воспользуются данным названием, чтобы лучше понять содержимое площадки и показать ее в ответ на соответствующий пользовательские запросы.

То есть слаг делает ваш сайт более удобным для ботов и людей помогает привлекать больше посетителей и продвигаться планомерно к верхушке поисковой выдачи.

Знакомимся с инструментами для выявления ошибок в URL Slug

На сегодня рынок IT-технологий предлагает нам достаточно много инструментов, при помощи которых каждый из вас сможет выявить ошибки в URL Slug. В частности, это может быть:

- Google Search Console.

- Netpeak Spider.

- Screaming Frog SEO Spider.

- Ahrefs.

С каждым из этих продуктов сейчас познакомимся более подробно.

Google Search Console для формирования качественных URL Slug

Google Search Console — это бесплатный, но вместе с тем очень полезный сервис от поисковой системы Google, который помогает владельцам сайтов следить за тем, как их страницы видны в поиске. Особенно полезным будет использовать этот инструмент в случаях, когда вы хотите сделать так, чтобы ваши URL-адреса, а также их слаги были максимально понятными, удобными и хорошо индексировались ботами.

Когда вы добавляете свой сайт в Google Search Console, сервис показывает, какие страницы уже попали в поиск, а какие еще не видны для пользователей. В разделе «Проблемы с индексированием» можно увидеть, почему некоторые адреса не отображаются в результатах поиска. Как вариант, это могут быть ошибки 404, неправильное перенаправление или же технические проблемы с самим URL-адреса. Среди прочего также проверит и URL Slug: если окажется, что в них присутствуют лишние символы, пробелы, кириллица или слишком длинные фразы, площадка известит вас об этом и вы сможете устранить проблему. В противном случае поисковик может не понять страницу и не показать ее людям.

Предположим, у вас сайт о рецептах, и вы создали страницу с адресом https://cooksite.com/recipes/letniy-salat-s-tomatami-i-kuritzey-2025. Если слаг слишком длинный или содержит спецсимволы, Google Search Console покажет, что такая страница плохо индексируется. Вы сможете быстро найти ошибку, исправить его на более короткий и понятный (например, «letniy-salat»). Не забудьте после внесения корректировок проверить, как изменится видимость страницы.

Сервис также помогает отслеживать, какие ключевые слова встречаются в ваших URL и насколько они совпадают с запросами пользователей. Например, если слаг страницы звучит как «remont-smartfona» и люди при этом ищут услугу «ремонт смартфона», Google Search Console покажет, что эта страница получает больше показов и кликов. Это значит, что правильно подобранный URL Slug помогает сайту расти в поиске и привлекать новых посетителей.

Еще одна полезная функция — проверка ошибок с дублирующимися адресами. Если у вас есть несколько страниц с похожими слаг, как вариант, «recept-salatа» и «recept-salatа-2025», сервис подскажет, что это может запутать поисковик и понизить позиции сайта. Вы сможете объединить такие страницы, настроить правильные редиректы и сделать структуру сайта более понятной.

Google Search Console также показывает, как часто пользователи кликают на ваши ссылки в поиске (CTR), и какие страницы при этом получают больше всего переходов. Практика показывает, что если слаг страницы простой и содержит нужные слова, люди чаще выберут именно ваш сайт. Это помогает понять, какие адреса работают лучше, а уже далее на основании полученной информации выполнить оптимизацию остальных URL.

То есть можно сказать, что Google Search Console — незаменимый помощник для тех, кто хочет сделать свои URL-адреса и слаг максимально удобными для людей и поисковых систем. С его помощью можно быстро находить и исправлять ошибки, улучшать структуру сайта и повышать его позиции в поиске.

Netpeak Spider для оптимизации URL Slug и структуры сайта

Netpeak Spider — это современный инструмент, предназначенный для комплексного SEO-аудита сайта. Чрезвычайно полезным он будет в случаях, когда есть необходимость сделать свои URL-адреса и слаги максимально понятными и удобными для поисковых систем и пользователей. С его помощью можно быстро найти и исправить ошибки, которые мешают сайту занимать высокие позиции в поиске и обеспечить себе стабильный приток посетителей.

Когда вы запускаете Netpeak Spider, программа сканирует все страницы вашего сайта и показывает подробный отчет по каждому адресу. Здесь вы получаете информацию о том, какие ссылки не работают (битые ссылки), где имеются проблемы со структурой URL, а также сможете быстро найти дублирующиеся страницы. То есть максимально быстрый просто вы сможете выявить все то, что способно запутать поисковики и снизить рейтинг сайта. Особенно важно это для слаг. Вы же знаете, если в нем окажутся лишние символы, пробелы, кириллица или слишком длинные фразы, это не хорошо для продвижения сайта в целом. Но сильно переживают здесь не стоит: Netpeak Spider сразу выделит такие ошибки и подскажет, что нужно исправить.

Предположим, если у вас сайт о ремонте техники и электроники, и адрес страницы выглядит как https://remontsite.com/uslugi/remont-smartdona. Здесь Netpeak Spider проверит, нет ли в слаг лишних знаков, двойных дефисов или заглавных букв. Если найдется ошибка, программа покажет ее в отчете, и вы сможете быстро изменить название на корректная, то есть, «remont-smartfona». В итоге поисковая система сможет корректно понять вашу страницу и повысить ее позиции в выдаче.

Удобно еще и то, что Netpeak Spider также помогает выявить технические проблемы, которые мешают индексации страниц. Например, если слаг содержит спецсимволы вроде %, &, + или пробелы, программа покажет, что такие адреса плохо воспринимаются поисковыми роботами и могут привести к появлению ошибок 404 или потере трафика в целом. Вы сможете оперативно исправить выявленные проблемы, тем самым обеспечив высокую доступность страниц вашего для поиска и непосредственно самих посетителей.

Еще одна полезная функция, которая предусмотрена в данном инструменте — анализ дублирующихся URL Slug. Если у вас есть несколько страниц с похожими адресами, Netpeak Spider подскажет, что это может привести к распылению ссылочной массы и снижению позиций сайта. Возможно, есть смысл объединить такие страницы, настроить правильные редиректы или же сделать структуру сайта более логичной и удобной для пользователей.

Помимо этого, Netpeak Spider позволяет отслеживать, как изменяются ошибки после внесения правок. Вы можете повторно запустить сканирование и убедиться, что все слаги стали чистыми, короткими и содержат нужные ключевые слова. Это особенно важно для крупных сайтов, где вручную проверить каждую страницу физически не представляется возможным.

Если вы хотите сделать свои URL-адреса и слаги максимально удобными для людей и поисковых систем, обратите внимание на Netpeak Spider. Вы увидите, насколько быстро просто можно будет выявлять существующие ошибки и устранять их тем самым улучшая структуру сайта и повышая его позиции в поиске. Это те моменты, которые обеспечат гарантированный росту трафика и увеличение числа клиентов.

Screaming Frog SEO Spider для анализа и улучшения URL Slug

Screaming Frog SEO Spider — это мощная программа, Предназначена для установки на компьютер. С ее помощью владельцы сайтов и SEO-специалисты смогут быстро находить и исправлять ошибки в адресах страниц, включая слаги. Этот инструмент особенно полезен тем, кто хотел бы сделать структуру своего сайта более понятной, а все URL-адреса — чистыми и удобными для поиска.

Когда вы запускаете Screaming Frog в работу, программа сканирует весь сайт и собирает подробную информацию по каждой отдельно взятый странице. В итоговом отчете программа покажет длину адреса, наличие редиректов, коды ответа сервера (например, 200 — все в порядке, или же 404, если страница не будет найдена), а также выявляет дублирующиеся адреса и контент. Это важно для SEO-продвижение в целом. И дело не только в том, что длинные, запутанные или повторяющиеся URL могут мешать сайту занимать высокие позиции в поиске, но и в других нюансах.

В разрезе темы URL Slug Screaming Frog особенно полезен тем, что позволяет быстро найти страницы с некорректными слагами. Как вариант, если у вас интернет-магазин электроники, и адрес товара выглядит как https://shoptech.com/products/12345?ref=abc, программа покажет, что такой слаг неинформативен и может отпугнуть посетителей. Screaming Frog поможет выявить и другие ошибки, в том числе слишком длинные URL Slug, наличие в них спецсимволов, пробелов, заглавных букв или же кириллицы. Вы сможете быстро отфильтровать такие страницы и изменить их адреса на более простые и понятные, например, https://shoptech.com/products/besprovodnye-naushniki.

Еще одна важная функция данного сервиса — анализ редиректов. Screaming Frog покажет, если страница с неправильным слаг перенаправляет на другую, и поможет убедиться, что все перенаправления настроены правильно. Это особенно важно при массовой замене структуры сайта или же оптимизации URL Slug: вы сможете избежать потери трафика и ошибок индексации.

Программа также помогает выявить дублирующиеся адреса и контент. Так, если у вас есть две страницы с похожими слагами, как https://shoptech.com/products/smartfon-2025 и https://shoptech.com/products/smartfon-2025-new, Screaming Frog покажет, что это может привести к путанице у поисковых систем и распылению ссылочного веса. Также вам будет предложено объединить такие страницы, настроить канонические теги или редиректы, чтобы структура сайта стала более логичной и удобной в первую очередь для пользователей.

Screaming Frog позволяет экспортировать все найденные ошибки в таблицу, чтобы вы могли обрабатывать их поэтапно. Это особенно удобно для крупных сайтов с сотнями и тысячами страниц, где вручную проверить каждый слаг невозможно. Программа также интегрируется с Google Analytics и Google Search Console, что позволяет отслеживать, как изменения в URL Slug влияют на посещаемость и позиции сайта.

То есть здесь мы можем сказать, что Screaming Frog SEO Spider — незаменимый помощник для тех, кто хочет сделать свои URL-адреса и slug максимально удобными для людей и поисковых систем. С его помощью можно быстро находить и исправлять ошибки, улучшать структуру сайта и повышать его позиции в поиске. В итоге это положительно скажется на росте трафика и увеличении числа клиентов.

Ahrefs для анализа URL Slug и SEO сайта

Ahrefs — один из чрезвычайно популярных и мощных на сегодня SEO-инструментов. Он помогает владельцам сайтов и маркетологам анализировать внешние и внутренние ссылки, а также состояние URL-адресов на площадки. Среди прочего его также можно использовать его в случаях, когда необходимо сделать свои URL-адреса и слаги более понятными и эффективными для поисковых систем и пользовательской аудитории.

С помощью Ahrefs вы можете узнать, какие страницы вашего сайта имеют наибольшее количество обратных ссылок. Это действительно важный показатель авторитета и популярности. Чем больше качественных ссылок ведет на страницу, тем выше ее шансы занять хорошие позиции в поисковой выдаче. Например, если у вас сайт о путешествиях, и страница с адресом https://travelblog.com/italy-rome имеет много ссылок с других ресурсов, поисковики будут считать ее более важной и показывать чаще в ответ на соответствующий пользовательский запрос.

Кроме того, Ahrefs равно как и другие сервисы, о которых мы говорили выше, помогает выявлять битые ссылки и редиректы на несуществующие страницы. Это важно, потому что такие ошибки ухудшают пользовательский опыт и снижают рейтинг сайта. Если в вашем магазине электроники есть ссылка на товар, которого уже нет, Ahrefs покажет эту проблему, и вы сможете быстро ее исправить, перенаправив пользователя на актуальную страницу.

Ahrefs также способен выявить дублирующийся контент и технические проблемы, которые могут мешать правильному ранжированию сайта. Например, если у вас есть несколько страниц с похожими URL, сервис укажет на это и предложит внести корректировки. Вы сможете настроить канонические теги или редиректы, чтобы избежать распыления трафика и повысить эффективность SEO-продвижения. Еще одна важная функция Ahrefs — анализ ключевых слов, которые встречаются в URL и содержимом страниц. Полученная информация позволит вам оптимизировать остальные URL и улучшить видимость сайта.

Используйте данный сервис в случае, если вы хотите сделать свои URL-адреса и слаг максимально удобными и эффективными как для людей, так и поисковых систем. С его помощью можно быстро находить и исправлять ошибки, улучшать структуру сайта и повышать позиции в поиске. Благодаря этому обеспечивается эффективное продвижение площадок в верхушку поисковой выдачи.

Ошибки, которые чаще всего встречаются при формировании URL Slug

Сейчас мы подробно познакомимся с теми ошибками, которые чаще всего выявляют на практике вышеприведенные сервисы при анализе URL Slug.

Закодированные URL

В процессе создания адресов страниц часто встречаются ситуации, когда в слаг попадают символы, что не предназначены для прямого использования в интернете. Это могут быть пробелы, кириллица или специальные знаки. К примеру, если вы ведете блог о путешествиях и создаете страницу с адресом https://travelblog.com/отдых-в-сочи, то кириллица в URL Slug автоматически будет закодирована браузером или сервером, и адрес превратится в https://travelblog.com/%D0%BE%D1%82%D0%B4%D1%8B%D1%85-%D0%B2-%D1%81%D0%BE%D1%87%D0%B8. Такой вид ссылки выглядит сложно, неудобно для чтения и может отпугнуть посетителей.

Помимо этого, закодированные символы, вроде %20 (это пробел), %D1%82 (кириллическая буква), или другие спецсимволы, делают адрес более длинным и непонятным. Пользователи до захода на сайт не смогут понять, о чем страница, а поисковые системы могут столкнуться с трудностями при индексации. Иногда серверы не обрабатывают такие запросы корректно, что приводит к ошибкам 404 или «битым» ссылкам, а это уже прямые потери трафика и позиций сайта. Часто такие ошибки появляются случайно: кто-то копирует название страницы с кириллицей или оставляет пробелы между словами.

Чтобы избежать подобных проблем, воспользуйтесь следующими рекомендациями:

- всегда используйте латинские буквы и дефисы для разделения слов в слаг;

- не применяйте пробелы, подчеркивания, спецсимволы и кириллицу;

- проверяйте адреса страниц при помощи тех сервисов, у которых мы говорили выше и исправляйте выявленные ошибки максимально оперативно;

- следите за тем, чтобы ваш слаг был коротким, понятным и отражал суть страницы.

Если вовремя выявлять и исправлять такие проблемы, ваш сайт будет выглядеть профессионально как в глазах ботов, так и обычных пользователей, а его страницы быстрее займут высокие позиции в результатах выдачи.

URL с лишними спецсимволами

В процессе создания адресов страниц иногда в них совершенно случайно появляются лишние символы, которые не нужны ни пользователям, ни поисковым системам. Это могут быть знаки %, &, +, {}, а также другие элементы. Как вариант, если у вас сайт о кулинарии, и адрес рецепта выглядит как https://cooksite.com/recipes/%best+salad{}, такой URL сразу вызывает вопросы: что это за символы и можно ли доверять такой странице?

Часто такие ошибки появляются, когда кто-то копирует название с лишними знаками или использует автоматическую генерацию адресов. Здесь важно понимать еще что поисковики предпочитают дефисы для разделения слов, а лишние символы могут запутать роботов и привести к ошибкам индексации.

Чтобы сделать URL-адреса чистыми и удобными воспользуйтесь следующими рекомендациями:

- используйте только латинские буквы и дефисы для разделения слов;

- избегайте лишних спецсимволов, кроме тех, что разрешены: / - + ? = & #;

- избегайте нижнего подчеркивания, заменяя его на дефис (-), чтобы поисковики правильно разделяли слова;

- после внесения корректировок обязательно настройте 301-редиректы со старых адресов на новые, чтобы не потерять трафик и сохранить позиции площадки;

- обновите все внутренние и внешние ссылки, что позволит избежать битых URL и потерь посетителей.

Если вовремя выявлять и исправлять подобное ошибки, сайт будет выглядеть профессионально, а страницы — быстрее попадать в поиск и привлекать больше людей.

URL с двойным дефисом

Иногда при создании адресов страниц на сайте появляются лишние дефисы как вариант, сразу после слэша, в конце адреса или даже два дефиса подряд. Это часто случается, если система автоматически переводит название страницы или товара в слаг, заменяя все пробелы и знаки препинания на дефисы без дополнительной проверки. Так, если у вас сайт о спорте, и вы добавляете статью «Лучшие упражнения для дома!», адрес может превратиться в https://sportblog.com/articles/-luchshie-uprazhneniya--dlya-doma. Здесь видно и дефис после слэша, и двойной дефис в середине, что в корне неверно.

Такие ошибки не всегда влияют на позиции сайта в поиске напрямую, но делают адреса страниц менее привлекательными и сложными для восприятия. Пользователь, увидев подобную ссылку может насторожиться, что автоматически снизит доверие к сайту. Помимо этого, длинные и запутанные URL сложнее запомнить и переслать другу. Такие проблемы часто возникают на сайтах с большим количеством товаров или статей, где слаг формируется автоматически.

Что делать, чтобы избежать таких ошибок? Вот несколько простых рекомендаций.

- проверьте структуру URL и удалите лишние дефисы, особенно в начале, в конце и между словами;

- используйте только один дефис для разделения слов, чтобы URL Slug был коротким и читабельным;

- после изменений обязательно настройте 301-редирект со старого адреса на новый, чтобы не потерять трафик и сохранить позиции сайта;

- обновите все внутренние и внешние ссылки, чтобы пользователи и поисковые системы всегда попадали на актуальную страницу.

Если вовремя исправлять такие мелкие ошибки, Вы обеспечите более эффективное попадание страничек в поиск, что станет залогом привлечения большего количества посетителей, а вместе с этим и эффективного продвижения сайта в целом.

URL с заглавными буквами

Иногда при создании адресов страниц на сайте используются заглавные буквы, как вариант: https://shoponline.com/Products/New-Arrivals. На первый взгляд может показаться, что это не проблема — адрес выглядит аккуратно и читаемо. Но для поисковых систем такие адреса, как https://shoponline.com/products/new-arrivals и https://shoponline.com/Products/New-Arrivals, считаются разными страницами. Это может привести к дублированию контента, когда одна и та же страница доступна по нескольким вариантам URL, отличающимся только регистром букв.

Такая ситуация опасна для SEO: поисковики могут запутаться, какому адресу отдавать приоритет, а часть ссылочного веса и трафика будет «распыляться» между дублями. В результате позиции сайта в поиске могут снизиться, а пользователи будут попадать на разные версии одной страницы, что усложняет навигацию. Как и в случае с другими ошибками подобная проблема актуальна для крупных сайтов, где адреса генерируются автоматически или редактируются разными сотрудниками.

Из практических советов в данном случае можно привести следующие:

- всегда используйте только прописные буквы во всех элементах URL, за исключением доменного имени;

- настройте 301-редиректы со всех вариантов адреса с заглавными буквами на основной, чтобы весь трафик и ссылочный вес переходил на правильную страницу;

- проверяйте структуру сайта и обновляйте внутренние и внешние ссылки, чтобы пользователи и поисковые системы всегда попадали на актуальную версию страницы.

Следуя таким рекомендациям, вы сможете сделать сайт более понятным для поисковиков, упрощайте сам его индексацию и помогая избежать технических проблем с дублями.

Дубликаты URL-адресов

Если проанализировать все варианты ошибок, то дублирующиеся адреса страниц на практике встречаются наиболее часто. Если говорить об интернет-магазин обуви, и один и тот же товар «черные кроссовки» может быть доступен по разным ссылкам, предположим https://shoeshop.com/catalog/black-sneakers, https://shoeshop.com/sale/black-sneakers и https://shoeshop.com/black-sneakers. То есть везде у нас одинаковый товар, но адреса получается разные. Проблема в том, что поисковые системы воспринимают все эти адреса как три разных страницы, хотя на самом деле контент один и тот же.

Такая ситуация приводит к путанице в работе поисковых ботов: они не могут понять, какой из адресов главный. В итоге в выдаче демонстрируется не та страница, которую вы хотели бы видеть в топе. Также наблюдается распыление ссылочного веса и ни одна из страниц не получает максимального преимущества. Это приводит к снижению позиции сайта в поиске, потере трафика и клиентов. Чаще всего дубли появляются из-за особенностей CMS, фильтров, сортировки товаров, UTM-меток или ошибок при настройке сайта.

Чтобы избежать дублей, воспользуйтесь такими советами:

- определите канонический адрес для каждой страницы;

- добавьте канонический тег (rel="canonical") на все дублирующие страницы, чтобы поисковики знали, какой адрес считать главным;

- настройте 301-редиректы с дублей на основной адрес, чтобы весь трафик и ссылочный вес переходил туда, куда нужно;

- проверьте и обновите внутренние ссылки на сайте, чтобы они вели только на каноничные страницы: это поможет избежать путаницы у пользователей и поисковых систем.

Если вовремя выявлять и устранять дубли, сайт будет лучше индексироваться, его страницы — выше ранжироваться, а пользователи всегда будут попадать на нужную информацию.

Подводим итоги

Правильная оптимизация URL-адресов и слаг — это важный шаг для любого сайта, который стремится быть заметным в поиске и удобным для пользователей. Чистые, короткие и понятные адреса страниц помогают не только поисковым системам быстрее индексировать сайт, но и посетителям легче ориентироваться в структуре ресурса. Если в URL Slug используются ключевые слова, они усиливают релевантность страницы и повышают ее шансы занять высокие позиции по нужным запросам.

Важно избегать типичных ошибок, о которых мы рассказали выше, а именно: не использовать лишние символы, пробелы, кириллицу, заглавные буквы и дублирующиеся адреса. Каждый слаг на вашем сайте должен быть уникальным и в точности отражать суть страницы. Для его написания используйте только маленькие латинскими буквами. Не стоит делать адреса слишком длинными или перегружать их датами и деталями — лаконичность и информативность всегда выигрывают.

Для крупных сайтов особенно важно сразу закладывать правильную структуру URL, чтобы избежать проблем с индексацией и потерей трафика. Если приходится менять адреса на уже работающем сайте, обязательно настраивайте 301-редиректы, чтобы сохранить позиции и не потерять посетителей.

Помните, что оптимизация URL — это не единственный фактор успеха, но он заметно влияет на SEO и восприятие сайта. Следуйте простым рекомендациям, используйте инструменты для проверки ошибок и регулярно обновляйте структуру адресов. Тогда ваш сайт будет расти в поиске, а пользователи — возвращаться снова и снова.

Но еще хотим обратить ваше внимание на такой инструмент, как мобильные прокси от сервиса MobileProxy.Space. С его помощью ваша работа по продвижению сайта станет максимально эффективной, гибкой, удобной и функциональной. Вы сможете отслеживать без проблем актуальные тенденции в вашей нише рынка по всему миру, обходя при этом региональные блокировки доступа. Также можно будет использовать автоматизированные решения для парсинга данных с сайтов конкурентов, запускать в социальных сетях мультиаккаунтинг и не только. Больше информации о функциональных возможностях данных мобильных прокси можно получить в разделе «Статьи».

Также у вас будет возможность совершенно бесплатно на протяжении 2 часов протестировать данный продукт, убеждаясь в его преимуществах непосредственно в разрезе вашего бизнеса. В последующем к вашим услугам будут специалисты круглосуточной службы технической поддержки. Больше информации можно узнать здесь.